I bot stanno disumanizzando Internet

La crescente quantità di contenuti e utenti generati dai software sta rendendo le piattaforme dei posti sempre più vuoti di relazioni sociali

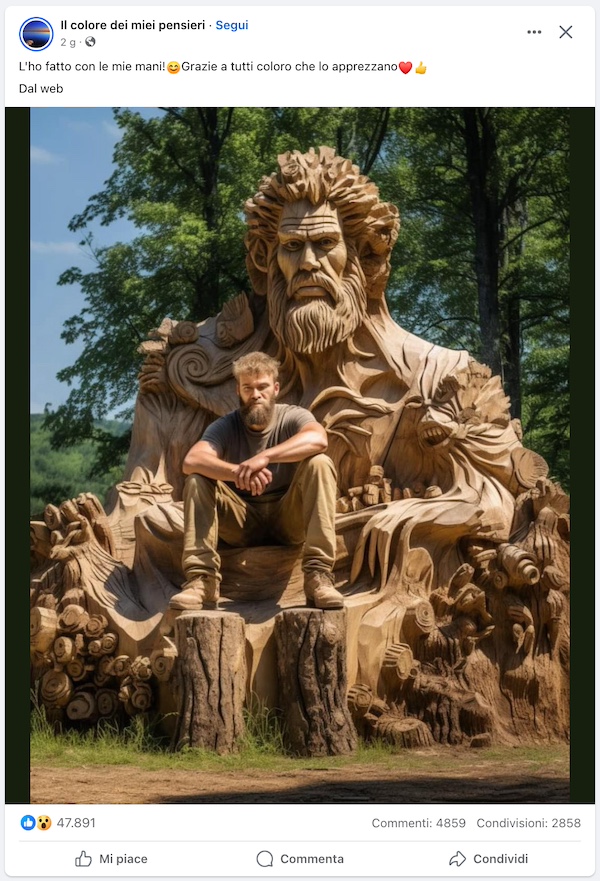

Nelle ultime settimane diversi siti di news e di tecnologia hanno ripreso e discusso una specie di teoria del complotto che circola almeno dal 2021, nota come Dead Internet Theory. È tornata di attualità in seguito alla diffusione crescente e apparentemente incontrollata su Facebook di immagini generate da software di intelligenza artificiale, molte delle quali grottesche e irrealistiche, ma molto visualizzate e commentate. Secondo la teoria, in origine condivisa da alcuni utenti su forum come 4chan, la maggior parte dei contenuti online sarebbe ormai generata automaticamente. E su Internet ci sarebbero ormai da tempo, all’incirca dal 2017, più bot che persone (con “bot” si intendono di solito software programmati per pubblicare, condividere e inviare messaggi).

Ripulita dai suoi tratti più assurdi, l’idea alla base della teoria ha stimolato negli ultimi tempi un dibattito serio. Riguarda i rischi di una trasformazione di Internet – secondo alcuni già in corso – da ambiente pensato per le interazioni virtuali tra persone reali ad ambiente “ibrido”, popolato da bot che parlano tra loro e persone incapaci di capire quali contenuti siano generati automaticamente e quali no. Riprendendo la teoria, il sito 404 Media (nato nel 2023 da un gruppo di fuoriusciti di Vice) ha scritto che Facebook non è la parte di Internet «morta», ma peggio: è una «Internet-zombie», fatta di bot, esseri umani e account un tempo umani ma ora non più.

La discussione è riemersa di recente in associazione a un esempio di immagine circolata su Facebook, il “Gesù di gamberetti”, citato in uno studio della ricercatrice statunitense Renée DiResta, responsabile della ricerca tecnica all’Osservatorio Internet di Stanford (un programma di ricerca dell’università statunitense di Stanford), e del ricercatore statunitense Josh A. Goldstein. Il nome si riferisce al bizzarro soggetto di alcune immagini generate tramite software di intelligenza artificiale e molto condivise su Facebook tra gli utenti di lingua inglese: immagini che mettono insieme l’iconografia classica di Gesù Cristo e varie rappresentazioni di gamberi (o altri crostacei).

Il Gesù di gamberetti – ma ci sono anche quelli di spaghetti, o di frutta – è il genere di immagini generate con software come DALL-E e Midjourney, che permettono di creare disegni a partire da istruzioni testuali. Su Facebook ne girano moltissime, inizialmente condivise da pagine inaffidabili, alcune delle quali gestite del tutto o in parte tramite algoritmi basati sull’intelligenza artificiale. Ed è un fenomeno che riguarda Facebook in generale, inclusi molti creatori di contenuti redatti in italiano e rivolti al pubblico italiano, e che spesso sfruttano proprio l’iconografia religiosa.

A seconda del soggetto, del livello di realismo e di altre variabili, le immagini riescono in molti casi a ottenere decine di migliaia di reazioni e condivisioni, sia da parte di account reali che da parte di account gestiti da bot. Sono di solito appositamente prodotte per stimolare reazioni e commenti, anche minimi (emoji, o parole come “amen”, “complimenti!” e “auguri!”): risultato che aumenta le probabilità delle immagini di finire sul feed di un gran numero di utenti. L’obiettivo di chi le diffonde è incrementare indirettamente le visite, e di conseguenza i ricavi pubblicitari, dei siti Internet associati alle pagine Facebook, che con una base di oltre tre miliardi di utenti è ancora la più grande piattaforma di social media al mondo, anche se molto meno rilevante e frequentata che in passato.

(Facebook)

Riferendosi a questo tipo di immagini il Guardian ha utilizzato la parola slop (“brodaglia”), suggerita da alcuni sviluppatori e informatici che per rendere più comprensibile il fenomeno sostengono sia necessario definirlo in un modo chiaro e condiviso (come già successo in passato con la parola “spam”, per esempio). A differenza dei chatbot, cioè i programmi in grado di sostenere conversazioni con le persone, lo slop non prevede interazioni con gli utenti, e non è prodotto per fornire loro delle risposte. È semplicemente fatto di contenuti che devono dare l’impressione di essere stati creati da un essere umano.

Lo studio di DiResta e Goldstein ha analizzato 120 pagine Facebook che avevano pubblicato almeno 50 immagini generate tramite software di intelligenza artificiale senza dichiararne la provenienza. E ha scoperto che questa tecnica è utilizzata da un’estesa rete di truffatori e abbindolatori, alcuni dei quali amministratori di più pagine. Un post con un’immagine generata automaticamente ha ottenuto 40 milioni di visualizzazioni ed è stato uno dei venti contenuti più visualizzati su Facebook nel terzo trimestre del 2023.

Spesso queste pagine pubblicano nel post l’immagine generata artificialmente, e soltanto nel primo commento un link che rimanda a un sito esterno, da cui dipendono i ricavi pubblicitari. È una tecnica comune che tiene conto della tendenza di Facebook a penalizzare i post che contengono link esterni rispetto a quelli che non ne contengono. Inoltre, scrivono DiResta e Goldstein, alcune pagine utilizzano anche pratiche fraudolente note, come il furto o l’acquisizione di account esistenti, e altri modi di accrescere artificiosamente il numero di follower.

– Leggi anche: Amazon si sta riempiendo di libri scritti con le intelligenze artificiali

DiResta e Goldstein hanno scritto che Facebook consiglia attivamente questi contenuti, mostrandoli anche nel feed di utenti che non seguono le pagine da cui provengono, né hanno mostrato interesse per quei contenuti. Parlando dei feed delle piattaforme di Meta, ma senza spiegarne il funzionamento nel dettaglio, il CEO Mark Zuckerberg ha detto ad aprile che «attualmente circa il 30 per cento dei post sul feed di Facebook viene fornito dal nostro sistema di consigli basato sull’intelligenza artificiale, e per la prima volta in assoluto oltre il 50 per cento dei contenuti che le persone vedono su Instagram è ora consigliato dall’intelligenza artificiale».

Alcuni commenti a immagini generate automaticamente – che raffigurano oggetti per la casa, paesaggi e presunte opere d’arte, per esempio – suggeriscono, secondo DiResta e Goldstein, che molte persone non siano consapevoli della provenienza artificiale delle immagini. In molti casi è un’informazione facilmente intuibile sulla base di alcuni difetti delle immagini dovuti a limiti tecnici del software (persone con sei dita, per esempio). In altri casi è più difficile essere certi dell’origine artificiale delle immagini, ha scritto il giornalista e cofondatore di 404 Media Jason Koebler, ed è ragionevole supporre che la difficoltà aumenterà con i progressi dell’intelligenza artificiale.

A complicare ulteriormente l’interpretazione dei contenuti contribuisce il fatto che una parte dei commenti e delle condivisioni proviene da account gestiti da bot, ma un’altra parte no. «Almeno in certi casi ci sono moltissimi commenti di account apparentemente reali di persone che dicono “Complimenti per la tua bellissima opera d’arte”, e non si rendono conto che si tratta di fake», ha detto Goldstein a 404 Media. Più che per il successo ottenuto dalle immagini su Facebook, ha aggiunto, «sono preoccupato per le persone che perdono la fiducia nella propria capacità di determinare ciò che è reale».

Per quanto problematica o sgradevole possa essere, la condivisione di immagini generate tramite software di intelligenza artificiale è sostenuta dall’economia stessa di Internet, ha scritto il Guardian. I modelli di intelligenza artificiale hanno reso persino banale la generazione automatica di grandi quantità di testo o di immagini, e di risposte a qualsiasi domanda immaginabile. E permettono anche di generare commenti a valanga per ogni post su Facebook. Basta una manciata di utenti che finisce su un sito esterno, fa clic su un banner o ricondivide un meme, e il costo della creazione del contenuto viene ripagato.

(Facebook)

L’unione tra un modello di business incentrato sulla pubblicità e la crescente disponibilità di software di intelligenza artificiale ha progressivamente trasformato la struttura e il funzionamento di Facebook. E l’ha resa un posto di fatto privo di relazioni sociali, ha scritto Koebler su 404 Media, attribuendo le ragioni della “zombificazione” della piattaforma non a incapacità tecniche di fondo, ma agli interessi commerciali di Meta, che promuove la circolazione di contenuti in grado di generare engagement (cioè tempo e attività dedicate alla piattaforma da ciascun utente).

La piattaforma è diventata qualcosa di peggio che bot che parlano con i bot. Sono bot che parlano con bot, bot che parlano con bot su indicazione di umani, umani che parlano con umani, umani che parlano con bot, umani che discutono su una cosa falsa fatta da un bot, umani che parlano con nessuno senza saperlo, account umani violati trasformati in bot, umani che temono che altri umani con cui stanno parlando siano bot, account ibridi umani/bot, la fine di una realtà condivisa e, al centro di tutto questo: una delle aziende più ricche del pianeta che rende possibile questo circo degli orrori perché i suoi dirigenti e azionisti umani hanno troppi soldi che dipendono dall’adozione di massa di una tecnologia rivoluzionaria, per fare qualcosa al riguardo.

Secondo un rapporto annuale della società di cybersicurezza statunitense Imperva, il Bad Bot Report, il 49,6 per cento di tutto il traffico Internet nel 2023 è stato generato da bot. È il valore più alto dal 2013, cioè da quando viene pubblicato il rapporto, e corrisponde a un aumento del 2 per cento rispetto all’anno precedente. Il 32 per cento del traffico è inoltre riconducibile proprio a «bot cattivi», cioè software programmati con l’obiettivo di danneggiare altri utenti (ne esistono anche di “buoni”). «I bot automatizzati supereranno presto la percentuale di traffico Internet proveniente dagli esseri umani, e cambieranno il modo in cui le organizzazioni si occupano della creazione e della protezione dei propri siti web e delle proprie applicazioni», ha detto Nanhi Singh, direttore generale per la sicurezza delle applicazioni presso Imperva.

– Leggi anche: Nella campagna di Elon Musk contro i bot di Twitter sono finiti in mezzo anche quelli “buoni”

Nick Clegg, responsabile degli affari globali di Meta e vice primo ministro del Regno Unito tra il 2010 e il 2015, ha annunciato a febbraio che Meta avrebbe introdotto un sistema sperimentale di individuazione e segnalazione di foto, video e audio generati tramite software di intelligenza artificiale. Inserire nei contenuti di questo tipo particolari metadati, che li rendano riconoscibili dai diversi sistemi di rilevazione, è l’idea alla base di un piano a lungo termine condiviso da Meta con aziende come Google, OpenAI, Microsoft e altre, ma che al momento è ancora molto teorico e appare difficile da realizzare.

Un altro modo per individuare contenuti generati automaticamente potrebbe essere affidarsi alle segnalazioni degli utenti. Ma come ha detto al Guardian Farhad Divecha, CEO dell’agenzia di marketing digitale AccuraCast, uno dei problemi di questo approccio è la quantità significativa di falsi positivi, cioè di persone che segnalano come prodotti dall’intelligenza artificiale contenuti che non lo sono. Questa tendenza indica peraltro un possibile abbassamento del livello di fiducia attribuita dagli utenti alle piattaforme: il rischio cioè che i consumatori comincino «ad avere l’impressione che viene servita loro spazzatura tutto il tempo», cosa che sarebbe «un problema per tutta l’industria dei social media», ha aggiunto Divecha.

– Leggi anche: E Apple che piani ha con l’intelligenza artificiale?

Infine, secondo altri studiosi che si sono occupati della Dead Internet Theory, eventuali preoccupazioni suscitate dall’incapacità di molte persone di capire su Internet cos’è generato automaticamente e cosa no dovrebbero essere estese anche a fenomeni meno innocui del Gesù di gamberetti. I ricercatori australiani Jake Renzella e Vlada Rozova hanno scritto sul sito The Conversation che la facilità con cui gli amministratori di pagine di social media riescono ad attirare l’attenzione e ad accrescere i follower utilizzando software di intelligenza artificiale è preoccupante anche e soprattutto perché i social sono la principale fonte di notizie per molti utenti in tutto il mondo.

Come ricordato da Renzella e Rozova, già in passato i bot sono stati utilizzati sui social media come strumento di disinformazione. E i precedenti indicano che pagine con un numero molto alto di follower inducono tendenzialmente gli utenti a considerare attendibili i contenuti diffusi da quelle pagine. I software di intelligenza artificiale sono inoltre già stati utilizzati in tempi recenti per la creazione di video, audio e foto credibili: per esempio, falsi video di celebrità statunitensi ed europee che criticano il presidente ucraino Volodymyr Zelensky, poi condivisi su Facebook e X in estese campagne di disinformazione. E anche se una gran parte delle campagne di questo tipo viene poi scoperta da inchieste giornalistiche o dagli utenti stessi, la circolazione molto estesa di particolari contenuti può comunque essere sufficiente a promuovere determinati sentimenti e influenzare l’opinione pubblica.

La teoria che Internet sia morta non dovrebbe essere intesa letteralmente come la fine della possibilità di qualsiasi interazione umana, secondo Renzella e Rozova. Ma è comunque una lente interessante attraverso cui osservare Internet e la sua evoluzione recente in ambiente «non più per umani da parte di umani». La libertà di creare e condividere pensieri personali è ciò che ha reso Internet così potente, ed è esattamente il potere che i malintenzionati cercano di controllare. La cosa buona della Dead Internet Theory è che ricorda alle persone di mantenere un approccio dubbioso quando utilizzano i social e le app, perché «qualsiasi interazione, tendenza e soprattutto “sentimento generale” potrebbe benissimo essere artificiale, progettato per cambiare leggermente il modo in cui percepisci il mondo».

– Leggi anche: Sui social funzioniamo come stormi