Le app che ricreano le persone che non ci sono più possono aiutare nel lutto?

I “griefbot” permettono di conversare con versioni virtuali dei morti, ma non ci sono prove dei loro benefici e sollevano diverse questioni etiche e di salute pubblica

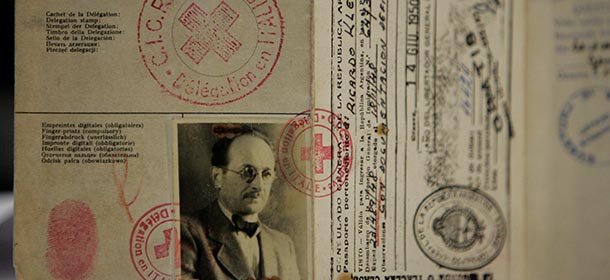

Nel 2022 una versione virtuale di Marina Smith, una donna di 87 anni del Nottinghamshire, partecipò in video al suo funerale a Babworth per rispondere a una serie di domande a lei poste da suo figlio e da altri amici e parenti che erano presenti. Smith, ex insegnante in pensione e cofondatrice dell’unico museo dedicato all’Olocausto in Inghilterra, alcuni mesi prima aveva accettato su proposta di suo figlio Stephen Smith, CEO dell’azienda californiana StoryFile, di “addestrare” un software di intelligenza artificiale in grado di creare soggetti virtuali utilizzando dati personali. A gennaio aveva quindi trascorso un paio di giorni a parlare della propria vita per qualche ora davanti a un computer che la riprendeva tramite una webcam.

I rapidi progressi compiuti nello sviluppo di software che simulano le conversazioni umane, di cui ChatGPT è l’esempio più noto, hanno da tempo portato l’attenzione sui molti ambiti sociali e lavorativi che potrebbero esserne influenzati in futuro o che in parte sono già cambiati. Da qualche anno diverse aziende stanno cercando di esplorare l’utilità e la redditività dell’intelligenza artificiale anche nell’elaborazione del lutto.

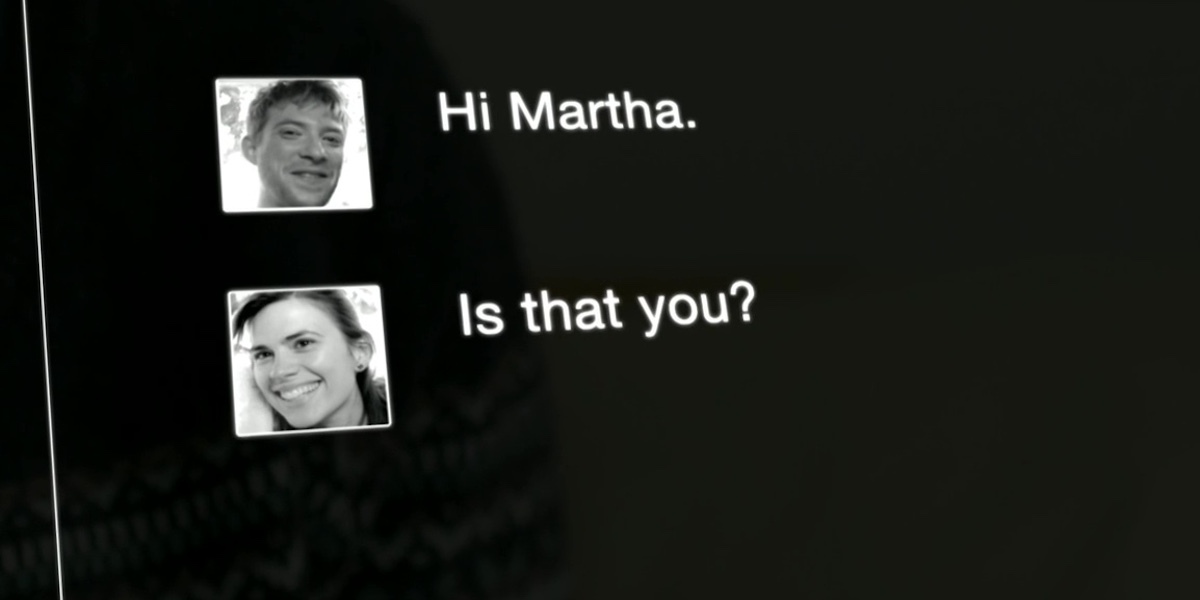

Uno degli sviluppi tecnologici più recenti nella gestione delle esperienze di dolore delle persone in lutto sono i “griefbot” (unione di grief, “lutto”, e bot). Sono particolari chatbot che permettono di simulare conversazioni con la versione digitale di una persona cara defunta, basati su software di intelligenza artificiale che fanno uso di modelli linguistici di grandi dimensioni (large language model, LLM). I dati utilizzati per addestrare i software possono essere email, messaggi di testo, note vocali, video e informazioni in altri formati relative al defunto.

Le aziende che offrono questo tipo di servizio, al momento perlopiù statunitensi, di solito non citano esplicitamente nella descrizione delle loro app il lutto come condizione in cui possono tornare utili. Non lo fanno perché di fatto si rivolgono a un pubblico più ampio, in parte sovrapponibile a quello degli utenti di app che permettono di avere conversazioni e relazioni con partner virtuali a partire da determinate indicazioni fornite dall’utente. Ma non citano il lutto anche per aggirare in parte questioni legali ed etiche di fondo, relative non solo al trattamento dei dati personali ma anche ai rischi nell’uso delle app da parte di soggetti in particolari condizioni di vulnerabilità e fragilità emotiva.

– Leggi anche: C’è chi è molto legato ai propri “partner virtuali”

Descrivendo un’app chiamata Vera AI, che sosteneva di permettere agli utenti di creare copie immaginarie di amici e familiari (al momento non più disponibile), il sito di tecnologia Futurism ha citato le reazioni critiche di diversi utenti sui social riguardo alla disponibilità di servizi di questo tipo negli app store. Ha inoltre fatto notare che, sebbene non sia chiaro che genere di dati la app utilizzasse, in una versione precedente della pagina di descrizione su Google Play l’installazione chiedeva l’autorizzazione ad accedere anche alla «memoria USB» e a «foto, contenuti multimediali e file» contenuti nel dispositivo.

Un’azienda californiana chiamata AE Studio fornisce un servizio ancora più esplicito, Seance AI, basato su modelli linguistici di grandi dimensioni e descritto come «l’incontro tra l’intelligenza artificiale e l’aldilà», per avere la possibilità che «i tuoi cari parlino ancora una volta al tuo cuore» (seance in inglese significa “seduta spiritica”). Un altro servizio chiamato YOV, acronimo di You, Only Virtual, permette di creare persone virtuali («versone») ed è descritto dal fornitore come un modo per tenere «la persona amata con sé per sempre» in modo da «non doversi mai dire addio».

Uno degli aspetti che complicano la questione dell’intelligenza artificiale applicata al lutto, già complicata di suo, è che la tecnologia presente nei servizi di questo tipo alimenta un’industria principalmente orientata al profitto. La maggior parte delle app per la creazione di persone virtuali tramite software di intelligenza artificiale è a pagamento. Le aziende produttrici che citano in modo esplicito il concetto di aldilà – o, più allusivamente, l’impossibilità di parlare con le versioni reali delle persone – si limitano a consigliare un utilizzo transitorio delle app per superare momenti difficili. E le opportunità commerciali proliferano in uno spazio grigio legislativo in cui i confini tra le app per la salute e quelle per il benessere non sono definiti in modo chiaro e rigido.

Anche ammesso che le aziende non siano unicamente motivate da interessi commerciali, il principale problema delle app per l’elaborazione del lutto basate sulla riproduzione artificiale di relazioni con la persona defunta è che non esistono prove scientifiche dei benefici di questa pratica. Esiste anzi nell’opinione pubblica un diffuso sospetto che possano incrementare il rischio di routine controproducenti e malsane, interferendo con i processi psichici alla base dell’elaborazione del lutto.

– Leggi anche: Quanto deve durare il lutto

Mantenere una qualche forma di legame psicologico con la persona defunta non è di per sé un fenomeno patologico o un comportamento da evitare, ammesso sia possibile farlo. Alcuni studi sostengono da tempo che l’elaborazione del lutto comporti di fatto una progressiva evoluzione di quel legame e una rimodulazione del senso che gli si attribuisce in modi che favoriscono l’adattamento alla perdita. Avere a portata di mano una fotografia di una persona cara defunta, rivederla in video o riascoltarla in vecchie registrazioni, per esempio, può aiutare alcune persone ad affrontare e superare il dolore per quella morte.

In determinate circostanze un legame duraturo può però diventare «disadattivo»: è il principale rischio a cui sembrano esposti a lungo termine gli utenti di app che utilizzano l’intelligenza artificiale non tanto per ricordare le persone defunte ma, in un certo senso, per imitarle. Le aziende che le producono, anziché svilupparle in modo irresponsabile e senza criteri suggeriti da specialisti, dovrebbero parlare con le persone che pensano di poter aver bisogno di questa tecnologia in modo da soddisfare esigenze specifiche, ha detto alla rivista Undark Carla Sofka, insegnante di studi sociali al Siena College, nello stato di New York, ed esperta di tecnologia applicata al lutto.

«Ogni persona è diversa nel modo in cui elabora il dolore», ha aggiunto Sofka, che non esclude che i griefbot possano diventare per alcune di loro un nuovo strumento per affrontarlo. Potrebbero però creare in altri utenti l’illusione che la persona cara non sia morta, e costringerli ad affrontare un secondo lutto qualora decidessero di smettere di usare il servizio. La preoccupazione più concreta condivisa da diversi esperti di salute pubblica e tecnologia è che i social chatbot possano in generale attivare meccanismi di dipendenza emotiva da conversazioni virtuali che impegnano per molto tempo le persone – tanto più quelle in lutto – e le escludono dalla vita sociale.

Per un progetto di ricerca un gruppo di studiosi della University of Kent, nel Regno Unito, e del Kyoto Institute of Technology, in Giappone, condusse nel 2023 una serie di interviste a dieci persone che in seguito a un lutto avevano utilizzato app per la creazione di persone virtuali. La maggior parte di loro portò avanti le conversazioni virtuali per meno di un anno, utilizzando le app soprattutto nella prima fase del lutto. Le persone intervistate dissero inoltre che il loro obiettivo non era creare versioni virtuali dei defunti per avere con loro una relazione duratura nel tempo.

Secondo il gruppo di ricerca serviranno altri studi per capire come i griefbot potrebbero influenzare in futuro l’elaborazione del lutto. In assenza di dati pubblici forniti dalle aziende produttrici, la difficoltà del gruppo a reclutare persone che ne facciano uso suggerisce che non rappresentino al momento un’applicazione dell’intelligenza artificiale molto diffusa. Ma le cose potrebbero cambiare, soprattutto se la crescente disponibilità di servizi del genere dovesse coincidere con una crescente carenza di professionisti qualificati della salute mentale.