Come le intelligenze artificiali disegnano il mondo

Dietro alle immagini sempre più realistiche di DALL•E c'è un complesso sistema artificiale di apprendimento

L’immagine che vedete qui sopra è stata disegnata appositamente per questo articolo, ma non ha richiesto al suo autore alcuna capacità o vena artistica. L’ha realizzata DALL•E, una intelligenza artificiale cui si può chiedere di disegnare qualsiasi cosa. Per illustrare visivamente l’argomento, la scarsa fantasia ha spinto l’autore di questo articolo a chiedere a DALL•E di disegnare «un robot che dipinge su tela su una spiaggia durante un tramonto» e questo è stato uno degli innumerevoli risultati possibili e sempre diversi che può produrre l’intelligenza artificiale.

DALL•E è uno degli algoritmi di intelligenza artificiale più discussi, apprezzati e criticati, soprattutto dalla fine dell’estate, quando una sua versione di prova è stata messa a disposizione di tutti consentendo a milioni di persone di sperimentare le sue capacità e di condividerne le immagini sui social network, o per illustrare gli articoli di giornale che ne parlano. Una prima versione di questa intelligenza artificiale era stata diffusa a gennaio del 2021, ma con capacità limitate rispetto a quelle attuali, che hanno sorpreso molti osservatori e suscitato la preoccupazione di illustratori, grafici e artisti.

Lo sviluppo di DALL•E è stato portato avanti da OpenAI, un laboratorio di ricerca in ambito informatico che fa parte dell’azienda OpenAI LP che a sua volta è controllata da Open AI Inc., una società senza scopo di lucro. L’organizzazione era stata fondata dal miliardario Elon Musk nel 2015, che si era poi dimesso dal suo consiglio di amministrazione tre anni dopo, rimanendone comunque un donatore.

In sette anni di attività, OpenAI ha sviluppato vari strumenti legati ai sistemi di intelligenza artificiale (AI), dedicandosi soprattutto ai modelli generativi che permettono di creare contenuti come testi e immagini originali, come nel caso di DALL•E. Il nome stesso di questa AI deriva dalla fusione di due parole: il nome di WALL-E, il robot del film Pixar, e quello dell’artista spagnolo Salvador Dalí, famoso per le sue opere surrealiste e dadaiste.

Specialmente grazie alla sua seconda versione disponibile da qualche mese, DALL•E è il sistema più conosciuto per produrre immagini con gli algoritmi, ma non è certo l’unico. Diversi altri gruppi di ricerca e sviluppatori, nonché società e varie organizzazioni, hanno realizzato AI che disegnano come Midjourney, Imagen e DreamStudio. Ognuno di questi sistemi impiega algoritmi diversi, ma con principi di funzionamento simili, anche se nella maggior parte dei casi nessuno riesce a offrire immagini così aderenti alle richieste come DALL•E. Il settore è comunque in piena espansione e porta a importanti miglioramenti a ogni aggiornamento, come dimostra l’evoluzione stessa di questa tecnologia che esiste da poco più di cinque anni.

Due tartarughe che giocano a calcio disegnate da DreamStudio

Per farsi un’idea di come DALL•E e le altre AI riescano a disegnare occorre infatti tornare indietro di qualche anno, quando iniziavano a diffondersi i primi sistemi di intelligenza artificiale in grado di descrivere autonomamente il contenuto di un’immagine digitale. Gli sviluppatori avevano sottoposto grandi quantità di immagini disponibili online – e descritte nel tempo dagli esseri umani, per esempio attraverso l’inserimento di didascalie – utilizzando vari sistemi di apprendimento automatico (“machine learning”) che avevano consentito alle AI di imparare a vedere da sole che cosa fosse contenuto in un’immagine priva di didascalie.

I primi modelli riuscivano a descrivere gli oggetti presenti nelle immagini fornendo semplici elenchi. Se in una fotografia si vedeva un ponte con alcune automobili al tramonto, l’AI restituiva come informazioni: ponte, automobili, sole. Grazie allo sviluppo di altri algoritmi, gli sviluppatori erano poi riusciti a far scrivere alle AI didascalie in linguaggio naturale, come quello che utilizziamo abitualmente per comunicare. La stessa didascalia poteva quindi essere resa con maggiore dettaglio e immediatezza: “automobili in viaggio su un ponte fotografato al tramonto”.

Partendo da questi progressi, tra il 2015 e il 2016 un gruppo di ricercatori si chiese se fosse possibile seguire un processo inverso: dare a una AI la descrizione testuale di un’immagine e fargliela disegnare da zero. Non volevano che la AI lo facesse recuperando immagini già esistenti da Google mettendole insieme, ma che l’algoritmo fosse in un certo senso in grado di immaginare ciò che gli veniva richiesto testualmente, traducendo il tutto in un disegno mai esistito prima. I Puffi sono strani ometti blu alti due mele o poco più, ma l’AI sarebbe stata in grado di disegnarne da zero di gialli alti come due angurie?

In uno studio pubblicato nel 2016, tre ricercatori dell’Università di Toronto (Canada) annunciarono di esserci riusciti, seppure facendo creare alle AI immagini molto piccole con una definizione di 32 per 32 pixel (lo schermo su cui state leggendo questo articolo ha molte migliaia di pixel in più). Chiesero al loro algoritmo di disegnare «un aereo di linea molto grande in volo in un cielo piovoso» e ottennero ciò che avevano chiesto, per quanto le immagini fossero piuttosto stilizzate e il lavoro più grande di immaginazione fosse poi richiesto al nostro cervello più che alla AI.

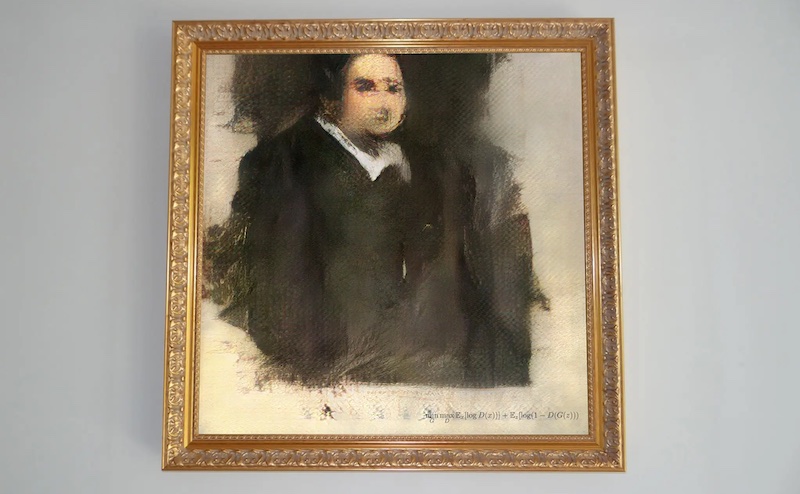

Quella ricerca di sei anni fa aveva mostrato che era effettivamente possibile passare da un testo a una immagine tramite una AI, anche se il sistema era ancora rudimentale. I progressi nel settore furono piuttosto rapidi e la stampa non di settore iniziò a parlarne nel 2018, quando un ritratto generato con un’evoluzione di quelle soluzioni fu venduto all’asta per 400mila dollari. In quel periodo le AI per disegnare erano soprattutto diffuse tra informatici professionisti e appassionati di informatica, con le conoscenze necessarie per calibrare gli algoritmi per ottenere specifici risultati. Altri disegni, che erano tutto sommato ancora una rarità, furono venduti all’asta a prezzi molto alti.

Il ritratto venduto all’asta nel 2018 per 400mila dollari (Christie’s)

I primi sistemi erano alquanto specializzati. Se volevi che facessero ritratti, dovevi istruirli per quella funzione sottoponendo loro grandi librerie di immagini di ritratti, mentre se volevi che disegnassero paesaggi dovevi utilizzare librerie diverse e in tema. Occorrevano poi conoscenze sui funzionamenti degli algoritmi per scegliere stile del disegno e numerose altre variabili. Una AI poteva essere un’abile ritrattista, ma una pessima paesaggista. Produrre scene più articolate, per esempio con il ritratto di un soggetto con un paesaggio sullo sfondo e disegnato in vari stili, non era possibile senza avere particolari conoscenze informatiche e avrebbe richiesto qualche altro anno di lavoro.

I risultati degli sviluppi più recenti sono i sistemi come DALL•E che riescono praticamente a disegnare qualsiasi cosa, con livelli di aderenza alle richieste sempre più alti. L’ultima generazione di queste AI è molto più semplice da utilizzare rispetto alle loro versioni di pochi anni fa. Proprio come avevano sperimentato i ricercatori in Canada nel 2016, ma con immagini molto più grandi e definite, ora è possibile scrivere una richiesta con un linguaggio naturale e ottenere in pochi istanti il disegno corrispondente. E si può chiedere davvero qualsiasi cosa, come «un soffice bradipo con un cappellino arancione fatto a maglia mentre prova a utilizzare un computer portatile, ravvicinato e con grande dettaglio, con luci da studio fotografico e un riflesso dello schermo nei suoi occhi» (un soggetto che sta ottenendo un certo successo) per ottenere il risultato che vedete qui sotto.

(DALL•E)

Complice la disponibilità di computer sempre più potenti e di librerie contenenti una sterminata quantità di immagini con le loro relative descrizioni, è stato possibile costruire set di dati molto ricchi con cui fare allenare le AI che devono imparare a disegnare. Molti pensano che queste immagini finiscano direttamente in ciò che viene disegnato, come una sorta di collage di oggetti già esistenti: chiedi “un bradipo al computer”, la AI cerca l’immagine di un bradipo e una di un computer e le mette insieme. Il funzionamento è però diverso, più affascinante e astruso per i non addetti ai lavori, ci prenderemo quindi qualche licenza per dare un’idea senza usare parole troppo complicate.

Una AI non “vede” le immagini come le vediamo noi: impara cose dai valori numerici che sono attribuiti a ogni pixel in base al loro colore e ad altre caratteristiche. Visto che ha a che fare con numeri, la AI cerca particolari relazioni matematiche e sulla base di queste metriche dispone ciò che vede in uno spazio matematico. Lo fa per diverse caratteristiche dell’immagine, imparando a distinguere gli oggetti (non ha naturalmente coscienza di che cosa siano, ma può imparare a riconoscerli e gestirli).

Semplificando moltissimo, per capire che un certo insieme di pixel rappresenta l’immagine di una palla da tennis o di una matita rossa, una metrica da considerare per l’AI può essere il colore: a un estremo dello spazio matematico c’è il giallo della palla da tennis e all’altro il rosso della matita.

Se aggiungiamo una matita gialla le cose diventano più complicate, perché per l’AI il colore non è più una metrica sufficiente per distinguere gli oggetti e ha quindi necessità di inserire un nuovo spazio matematico riferito per esempio alla forma. Ora l’AI può mettere le due matite in relazione tra loro per la forma allungata, distanziandole dalla palla da tennis che è invece rotonda. Quest’ultima sarà comunque in relazione con la matita gialla, per via del colore.

In questo esempio di Vox, l’AI lavora sulle differenze e le somiglianze tra pixel che messi insieme rappresentano delle banane o dei palloncini (Vox)

Gli algoritmi di “deep learning” (letteralmente “apprendimento profondo”) sono coinvolti in questo processo di raccolta delle variabili che vengono poi impiegate per creare metriche e spazi. Man mano che si aggiungono nuove variabili, come brillantezza degli oggetti o forme inattese degli stessi (una matita spezzata, una pallina da tennis rotta e deformata o sporca di fango, quindi non più gialla), aumentano gli spazi matematici con una grande quantità di dimensioni. Per il nostro cervello abituato alle tre dimensioni, immaginare questi spazi multidimensionali, o per meglio dire “modelli latenti”, non è semplice, ma è dalla loro esistenza e intricatissima rete di relazioni che l’AI impara non solo a riconoscere gli oggetti, ma anche a disegnarli da zero quando le viene richiesto.

Un modello latente può avere al proprio interno centinaia di dimensioni che identificano particolari caratteristiche di come sono fatte e appaiono le cose: la forma che hanno le matite, i loro colori e i contesti in cui sono utilizzate, il modo in cui appaiono nelle foto d’epoca, il modo in cui l’acqua le riflette e tantissime altre variabili, alcune delle quali sono “comprensibili” solo alle AI e non a noi.

Essendo basato su valori numerici, lo spazio latente ha specifiche coordinate per ogni punto, che rappresenta la distanza o la vicinanza da particolari caratteristiche degli oggetti. La richiesta di un “soffice bradipo” fa sì che la AI risalga alle coordinate di ciò che è un bradipo, alla sua distanza nello spazio matematico dagli oggetti soffici e poi ancora a tutte le altre sottovariabili, come il pelo, il suo colore e le sue caratteristiche, sempre in relazione alla richiesta.

Le coordinate devono essere poi tradotte da uno spazio prettamente matematico a uno spazio che possiamo vedere e interpretare anche noi, cioè un’immagine. Questo passaggio intermedio ed essenziale è un processo generativo che si chiama “diffusione”. Il sistema inizia con una serie piuttosto confusa di pixel e attraverso una serie di cicli (iterazioni) mette via via ordine nell’immagine, creandone una che abbia senso per noi e che risponda alla richiesta ricevuta. In sostanza la AI migliora l’immagine a ogni iterazione, derivando di volta in volta dall’immagine che ha creato le informazioni per renderla migliore. È un processo molto articolato reso possibile da sistemi di codifica e decodifica di ciò che sta facendo la AI (“segnale”) in cui non ci addentreremo. Anche qui, prendendoci moltissime licenze e al solo scopo di dare un’idea, potete pensare a quando si impara a suonare a orecchio una canzone con la chitarra, costruendo la melodia sulla base dei tentativi precedenti migliorando man mano tempo, ritmo e accordi fino ad arrivare a un risultato coerente, che “suona” come volevamo.

Poiché ci sono modelli latenti fatti diversamente – sulla base dei parametri scelti dai programmatori e delle immagini su cui sono state formate le AI – le immagini risultanti dalle richieste possono variare moltissimo a seconda del prodotto finale che viene utilizzato. Gli sviluppatori possono inoltre aggiungere ulteriori algoritmi per affinare la vena artistica della loro AI, per esempio utilizzando nella fase di apprendimento set di immagini che si avvicinano al gusto estetico generale di ciò che troviamo piacevole o non piacevole alla vista.

Molti aspetti del funzionamento di DALL•E non sono noti, ma i suoi programmatori hanno segnalato di avere aggiunto elementi per far sì che le immagini prodotte rispondano a un certo gusto estetico. Nei limiti del possibile, la AI produce immagini che dovrebbero piacerci e di conseguenza che riteniamo più aderenti alle nostre richieste, amplificando quell’impressione di avere davanti proprio ciò che avevamo chiesto.

Nell’immagine qui sotto, prodotta chiedendo uno “scoiattolo che legge una mappa di Milano”, lo scoiattolo appare come ci immaginiamo di solito questi animali: di lato, in posizione semieretta e con le zampe anteriori vicine al muso. La mappa non rappresenta nel dettaglio Milano, ma è come ce la immagineremmo: con un intrico di vie, alcune linee colorate che indicano i percorsi della metropolitana e aree verdi per i parchi cittadini. L’immagine ha un discreto livello di dettaglio, sufficiente per indurre il nostro cervello a completare le parti mancanti. Si avvicina al nostro gusto estetico, o a come immagineremmo uno scoiattolo alle prese con una mappa, e di conseguenza attribuiamo alla AI una capacità di “immaginare” e produrre l’immagine ancora più alta: proiettiamo qualcosa di noi stessi sulle sue capacità.

(DALL•E)

Un grande numero di dimensioni fa sì che la AI possa inoltre imitare stili molto diversi tra loro, che possono essere compresi nella richiesta. Se per esempio si chiede “Napoleone in un poster sovietico” si ottiene un risultato coerente, con una buona approssimazione. L’AI mostra però di non riuscire sempre a disegnare le fattezze di un determinato personaggio, e anche in questo caso molto dipende dal set di immagini che ha impiegato per imparare a disegnare.

(DALL•E)

La capacità di imitare gli stili è comunque notevole specialmente nel caso di DALL•E. Se si chiede “un astice che guida un’auto di Formula 1 al Gran Premio di Montecarlo, in stile Disney” si ottiene un disegno che coglie indubbiamente il senso della richiesta e che potrebbe essere scambiato per il lavoro di un illustratore in carne e ossa.

(DALL•E)

E proprio chi si occupa di grafica e illustrazioni negli ultimi mesi ha iniziato a mostrare una certa preoccupazione, talvolta insofferenza, verso le AI che disegnano e che riescono a farlo sempre meglio. Un giorno, forse nemmeno troppo lontano, per alcuni tipi di illustrazioni il lavoro dei professionisti potrebbe essere sostituito dalle AI, cosa che non è avvenuta in altri settori dove si sperimentano da tempo le intelligenze artificiali, come nella produzione di testi, dove ci sono ancora enormi margini di miglioramento. I progressi nel disegno con le AI sono stati più veloci e sono soprattutto più promettenti, da qui le numerose preoccupazioni espresse in questi mesi.

– Leggi anche: A chi appartengono le immagini generate dalle intelligenze artificiali?

Come tutte le tecnologie che esistono da poco tempo, ci sono grandi interrogativi sulle implicazioni di DALL•E e dei suoi simili. A oggi non ci sono regole sul diritto d’autore sulle immagini generate dalle AI, così come non è chiaro come debba essere gestito il copyright delle immagini che vengono impiegate per addestrare le intelligenze artificiali a fare i disegni. Una fedele illustrazione di Paperino fatta da una AI in che categoria ricade? In quella di una riproduzione per cui è necessario pagare i diritti a Disney o in un’opera d’arte che segue quindi strade diverse legate al diritto d’autore? E anche se ci fossero diritti da pagare a chi spetterebbe l’onere?

Ci sono poi problemi legati ai pregiudizi e ai preconcetti introdotti nelle AI direttamente dagli sviluppatori, anche solo inconsapevolmente perché vivono in una certa parte di mondo e non in un’altra o per via del loro genere, o dalle immagini su cui sono stati poi elaborati i modelli. Se nei set di immagini sono rappresentati soprattutto uomini bianchi in posizioni di potere, l’AI rifletterà questa condizione quando la richiesta sarà “presidente di governo mentre tiene un discorso da un podio”. Discriminazioni legate al genere, alla provenienza geografica o a particolari disabilità possono essere riflesse nei disegni delle AI e a volte amplificate, come già avvenuto in passato in esperimenti finiti malissimo.

I meno critici rispetto a questi problemi dicono che in fin dei conti con il loro comportamento le AI riflettono quello delle società che le hanno prodotte, dunque non offrono modelli peggiori della realtà. E che se si vogliono cambiare le cose in generale, il miglioramento deve avvenire prima al di qua dello schermo perché possano essere poi riflesse in una multidimensione di spazi matematici che farà esistere un simpatico bradipo con un cappellino di lana, intento a usare un computer.