Vocabolario minimo dell’intelligenza artificiale

AGI, agente, GPU, LLM, slop e altri termini che è ora di imparare, spiegati

Comprendere il dibattito sull’intelligenza artificiale è importante per orientarsi in una questione che sta diventando centrale e mainstream in sempre più ambiti professionali e non. Ma il dibattito sull’intelligenza artificiale è fatto tanto di “fuffa”, discorsi inconsistenti e generici che si sentono sempre più spesso persino in tv, quanto di gergo specialistico senza il quale si è esclusi da parte della conversazione. Se nel primo caso per non sentirsi disorientati conviene smettere di ascoltare, nel secondo torna utile un ripasso sulle parole più importanti e utilizzate quando si parla di AI.

AGI

La sigla più citata e abusata del settore: sta per Artificial General Intelligence (anche detta in italiano Intelligenza artificiale forte) e indica un’AI in grado di apprendere qualsiasi compito intellettuale che possa essere imparato da un essere umano. Di AGI parlano ricercatori, specialisti e imprenditori, a volte per indicare la via per una nuova utopia, a volte per lanciare moniti sulla fine del mondo.

Tuttavia, non esiste una definizione chiara di AGI né una serie di regole condivise per stabilire il punto oltre il quale un’AI diventerebbe «generale». Anche le tempistiche sono confuse: per alcuni si tratta di una tecnologia raggiungibile nel giro di pochi anni; per qualcuno è un obiettivo troppo vago e lontano; e per altri, infine, sarebbe addirittura già qui.

Sotto molti aspetti, AGI è diventata una buzzword (vedi: Superintelligenza), un termine utilizzato dal marketing con cui si descrive una presunta evoluzione degli attuali modelli linguistici di grandi dimensioni (LLM), presentati come capaci di sostituire gli esseri umani in un numero crescente di compiti cognitivi.

– Leggi anche: Quando un’intelligenza artificiale diventa troppo potente?

AI generativa

Il campo dell’intelligenza artificiale è molto più ampio dei chatbot diventati popolari negli ultimi anni. Prodotti come ChatGPT, Claude e Google Gemini sono applicazioni basate su modelli di intelligenza artificiale generativa, un tipo particolare di AI progettato per produrre contenuti (testi, immagini, audio o video) a partire dalle indicazioni fornite dagli utenti.

Alla base di queste applicazioni ci sono i cosiddetti foundation model, modelli addestrati su enormi quantità di dati e pensati per essere adattati a usi diversi, e non per un compito specifico. Tra i più diffusi ci sono i Large Language Model (LLM), utilizzati per la generazione e l’analisi del linguaggio, il cui sviluppo richiede tempi lunghi e grandi risorse computazionali.

Agente/agentico

Per “agente” si intende un sistema di intelligenza artificiale in grado di svolgere azioni online per conto dell’utente, in modo autonomo. Un esempio comune è quello dell’organizzazione delle vacanze: basta dire a un chatbot “agentico” la destinazione, il periodo e un budget massimo perché confronti voli aerei, alberghi e spostamenti, proponendo un itinerario e, nel caso, prenotando direttamente a nome dell’utente.

I sistemi “agentici” sono stati una delle tecnologie più attese del 2025 e vengono considerati la naturale evoluzione dei chatbot. Nel corso dell’anno, aziende come OpenAI e Perplexity hanno reso disponibili dei nuovi browser con funzioni agentiche, rispettivamente ChatGPT Atlas e Comet, capaci di analizzare l’attività degli utenti e intervenire direttamente per svolgere azioni al posto loro. Nonostante l’hype sul concetto di agente, però, questi sistemi sono ancora limitati e poco affidabili.

Allucinazione

Nel 2023 il matematico australiano Rodney Brooks, docente di robotica presso il MIT di Boston, definì ChatGPT uno strumento che «inventa cose che sembrano giuste». Nel 2021 questi sistemi erano stati anche definiti «pappagalli stocastici» (o «pappagalli probabilistici») proprio perché producono frasi che hanno senso ma che essi non sono necessariamente in grado di capire.

Secondo questa visione, i chatbot comunicano senza sapere davvero cosa dicono, basandosi su complessi calcoli di probabilità, che nella stragrande maggioranza dei casi risultano corretti agli occhi umani. Non mancano però gli errori, che vengono detti «allucinazioni» anche per sottolineare l’assurdità che spesso li caratterizza. Questi errori, infatti, non riguardano tanto le regole grammaticali, quanto la presenza di elementi e fatti completamente inventati, che vengono presentati convintamente come veri.

– Leggi anche: L’anno dell’intelligenza artificiale

Antropomorfismo

Nel giugno del 2022, pochi mesi prima che ChatGPT andasse online, un ricercatore di Google, Blake Lemoine, rivelò al Washington Post che LaMDA, un chatbot in fase di sviluppo all’interno dell’azienda, era diventato «senziente», ovvero cosciente di sé. L’allarme si rivelò infondato e Lemoine fu licenziato da Google, ma la vicenda confermò una tendenza istintiva degli esseri umani, spinti a intravedere caratteristiche umane negli oggetti e strumenti che usano. Anche nelle AI.

Questo fenomeno, detto antropomorfismo, può spingere alcuni utenti a considerare i chatbot degli amici, se non addirittura dei partner sentimentali con cui instaurare un rapporto intimo. L’antropomorfismo viene sfruttato anche dalle stesse aziende tecnologiche, che hanno imparato a usare un tono e un linguaggio umani per consolidare il rapporto con i propri utenti, arrivando a offrire dei companions, ovvero chatbot da compagnia, come nel caso di xAI e Character.AI.

– Leggi anche: Storie di interazioni con ChatGPT finite molto male

Benchmark

LMArena è una piattaforma in cui gli utenti possono mettere alla prova e confrontare le prestazioni di diversi LLM, proponendo loro prove di vario tipo. Le performance dei vari modelli vengono poi misurate per determinare quali sono i più veloci e potenti. Alla base di queste valutazioni ci sono i benchmark, dei test standardizzati nati per mettere alla prova le AI nel ragionamento e nella capacità di comprensione o di generazione di contenuti.

– Leggi anche: Come sono i chatbot di intelligenza artificiale a confronto

Bias

Per bias si intende qualsiasi pregiudizio o distorsione che può influenzare in qualche modo i contenuti generati dalle intelligenze artificiali. Questi pregiudizi possono essere contenuti negli stessi dati di addestramento, finendo per riflettersi nelle risposte generate dal sistema. L’esempio più comune di bias nelle AI riguarda però gli algoritmi di riconoscimento facciale, che tendono a commettere più errori (come falsi positivi o falsi negativi) quando analizzano persone nere. Una delle cause del fenomeno è la scarsa diversità etnica presente nelle immagini e nei video su cui questi modelli vengono sviluppati.

Il cosiddetto bias algoritmico può verificarsi anche nelle fasi successive dello sviluppo di questi sistemi. Secondo Timnit Gebru, ex ricercatrice di Google, sarebbe causato anche dalla scarsa diversità etnica e di genere che caratterizza la maggior parte dei team che si occupano di AI, dove lavorano poche donne e poche persone nere.

Chatbot

Un chatbot (o chatterbot) è un software progettato per simulare una conversazione con un essere umano utilizzando il linguaggio naturale, invece di quello informatico. Il primo chatbot della storia, ELIZA, fu sviluppato nel 1966 dall’informatico tedesco Joseph Weizenbaum; nel corso dei decenni successivi la tecnologia ha permesso di migliorarli e potenziarli continuamente, rendendoli sempre più realistici e potenti.

La distinzione tra un chatbot e un modello linguistico è sottile ma cruciale: il chatbot è l’interfaccia attraverso cui l’utente interagisce con un modello linguistico. ChatGPT, ad esempio, è il chatbot, mentre GPT-5 è il suo modello linguistico.

Data center

Un data center è una struttura, che può essere una singola stanza o un intero edificio, destinata a ospitare l’infrastruttura tecnologica fondamentale per l’erogazione di servizi e applicazioni online, o per la conservazione dei dati. La loro importanza e dimensione sono aumentate significativamente nel tempo, prima con la diffusione del cloud computing e più recentemente con quella delle AI. L’adozione del cloud ha reso necessario lo sviluppo di queste infrastrutture, perché consente agli utenti di accedere a dati e servizi da remoto, anziché sui loro dispositivi.

La maggiore potenza di calcolo richiesta dall’uso crescente dell’AI generativa ha accelerato l’espansione dei data center, con molte aziende che stanno investendo decine di miliardi di dollari per la loro costruzione. L’impatto ambientale di queste strutture, particolarmente energivore, sta diventando una questione politica sempre più rilevante, specialmente negli Stati Uniti, dove si concentra la maggior parte degli investimenti nel settore.

– Leggi anche: Stiamo costruendo troppi data center per l’intelligenza artificiale?

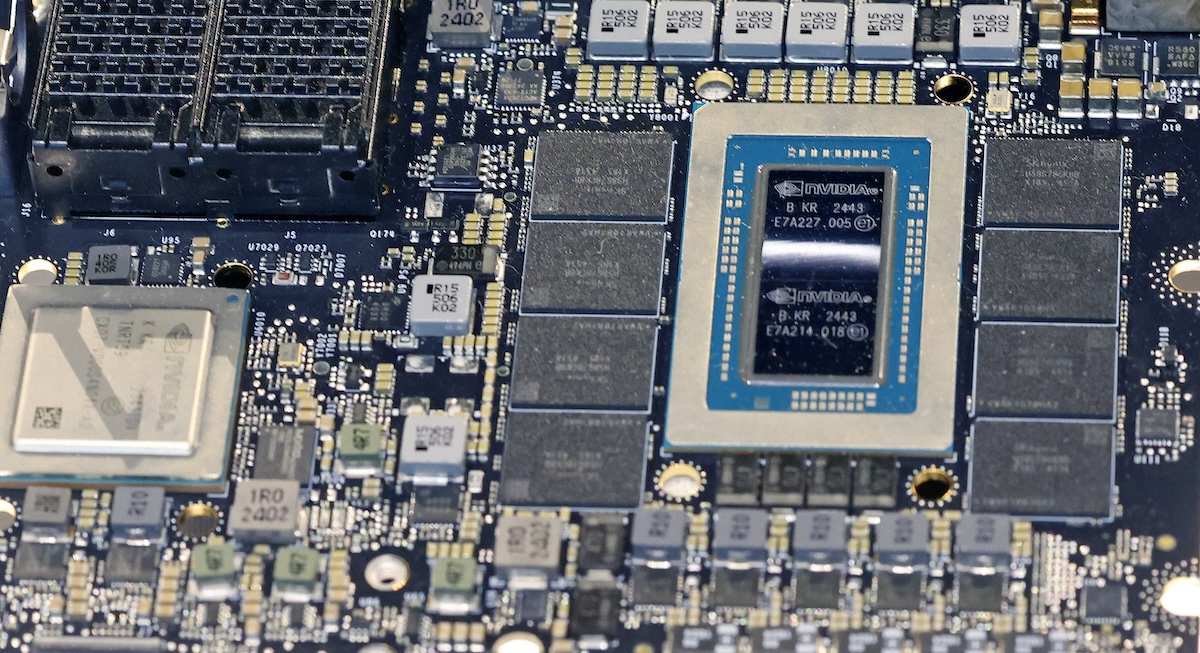

GPU/TPU/NPU

Una Graphics Processing Unit, o unità di elaborazione grafica (GPU), è un processore progettato per accelerare e migliorare la creazione di immagini. Le GPU sono specializzate nel calcolo parallelo, un processo che consiste nel suddividere problemi di calcolo complessi in segmenti più piccoli, che possono essere risolti in modo simultaneo da più processori. Col tempo le alte prestazioni di questi chip hanno trovato applicazioni in altri settori, tra cui il mining di criptovalute e, più recentemente, lo sviluppo e il funzionamento delle intelligenze artificiali generative.

Il termine GPU è stato popolarizzato da Nvidia nel 1999 con GeForce 256, una scheda video pensata per migliorare la resa grafica dei videogiochi, in particolare nelle applicazioni 3D. Da allora l’azienda, fondata nel 1993, è leader del mercato delle GPU, e, grazie all’enorme interesse per l’AI, l’anno scorso è diventata la società con il più alto valore in borsa al mondo.

Le Tensor Processing Units (TPU) sono invece dei chip alternativi sviluppati da Google che vengono utilizzati dall’azienda nei propri data center per l’addestramento e l’esecuzione dei modelli di intelligenza artificiale, tra cui Gemini 3. A differenza delle GPU, nate per migliorare la grafica dei videogiochi, le TPU sono state concepite fin dall’inizio per ottimizzare i calcoli tipici delle reti neurali.

Un altro tipo di processore utilizzato in questo ambito è la Neural Processing Unit (NPU), pensata per offrire buone prestazioni con un’elevata efficienza energetica. A differenza di GPU e TPU, spesso impiegate nei data center, le NPU sono progettate per essere integrate direttamente in computer e smartphone, consentendo l’elaborazione dei dati in locale, senza doverli trasmettere continuamente al cloud.

Guardrail

Un modello generativo è, in linea di principio, in grado di produrre testi, immagini o video su un’ampia gamma di argomenti, senza limiti al di là di quelli tecnici. Proprio per questo, i servizi che li utilizzano sono solitamente dotati di sistemi di sicurezza che impongono vincoli al loro funzionamento, sia per garantire un’esperienza d’uso migliore, sia per evitare che vengano impiegati in attività illecite o pericolose.

Questi vincoli sono generalmente indicati con il termine guardrail e servono a limitare la diffusione di disinformazione, la divulgazione di dati personali protetti (che potrebbero far parte dei dati di addestramento o essere forniti dagli utenti) e, più in generale, a ridurre il rischio di abusi da parte degli utenti.

– Leggi anche: Che ne è stato della cautela nel settore delle intelligenze artificiali?

LLM

Un Large Language Model (LLM) è un tipo di intelligenza artificiale basato su reti neurali profonde, addestrato su enormi quantità di testi per imparare a comprendere e generare linguaggio scritto. Viene definito «di grandi dimensioni» per l’elevatissimo numero di parametri (cioè di variabili interne) utilizzati per analizzare i dati durante la fase di addestramento.

Volendo semplificare, un LLM funziona calcolando la probabilità che un token (cioè una parola o una parte di parola) ne segua un altro all’interno di una frase. A partire dall’input fornito dall’utente, il modello genera il testo in modo sequenziale, scegliendo di volta in volta il token più probabile, producendo così una risposta coerente.

Machine learning/Deep learning

Per machine learning (ML, in italiano apprendimento automatico) si intende l’attività di apprendimento dei computer attraverso i dati. Il machine learning si basa sull’analisi di grandi quantità di informazioni per individuare andamenti, schemi ricorrenti e correlazioni, a partire dai quali è possibile formulare previsioni in modo statistico. L’apprendimento può essere supervisionato, se il sistema viene addestrato a partire da esempi forniti dagli sviluppatori; non supervisionato, se individua autonomamente strutture e relazioni nei dati; o per rinforzo, quando il modello migliora attraverso tentativi ed errori.

Il deep learning è invece una sottocategoria del machine learning, con cui viene spesso confuso. Questo tipo di apprendimento si basa su una particolare struttura di algoritmi ispirata alle reti di neuroni del cervello umano, e consente un apprendimento più sofisticato rispetto ad altri modelli di ML.

Multimodale

Nella sua prima versione, ChatGPT era un sistema “unimodale”, cioè in grado di comunicare solo testualmente, ricevendo istruzioni scritte e rispondendo esclusivamente con testi. Col tempo ChatGPT e gli altri chatbot sono diventati sistemi multimodali, ovvero capaci di elaborare e generare informazioni attraverso diversi formati, come testi, immagini e audio. La multimodalità di questi sistemi consente ad esempio di mostrare a un’AI una fotografia di un paesaggio o di una scritta per chiederne un’analisi o una traduzione, ottenendo una risposta scritta da un input visivo.

Prompt

Un prompt è, generalmente, qualsiasi indicazione data a un computer usando il linguaggio naturale, cioè quello utilizzato dalle persone per comunicare. Nel campo dell’AI generativa indica la richiesta dell’utente, mentre la risposta generata dal chatbot è comunemente detta output. Dopo il lancio di ChatGPT, nel novembre 2022, si è diffuso anche il prompt engineering, l’insieme di strategie e tecniche per formulare istruzioni il più precise possibile, in modo da guidare l’intelligenza artificiale verso risultati più accurati e utili.

Slop

Slop è una parola inglese che significa “sbobba”, che a partire dal 2024 è stata utilizzata per indicare in modo spregiativo i contenuti dozzinali, assurdi, derivativi e di pessimo gusto generati massicciamente con l’intelligenza artificiale e pubblicati online. La diffusione del termine si è accompagnata a quella di immagini e video generati dalle AI, che sono sempre più presenti sui social media e sul web in generale, tanto da aver convinto il dizionario inglese Merriam-Webster a scegliere slop come parola dell’anno per il 2025. Uno degli esempi più noti di slop è il cosiddetto «Gesù di gamberetti», una serie di immagini bizzarre e virali comparse perlopiù su Facebook nel 2024.

– Leggi anche: I bot stanno disumanizzando Internet

Superintelligenza

Secondo il filosofo svedese Nick Bostrom, una Superintelligenza Artificiale (ASI) è un livello teorico di intelligenza artificiale che supera di gran lunga le capacità cognitive umane in quasi tutti i campi. Si tratta, quindi, di un tipo di AI nettamente più avanzato rispetto a quelli attuali, dotato di capacità intellettive superiori a quelle umane.

Recentemente, il termine è stato adottato anche da Meta, che ha investito decine di miliardi di dollari per formare un nuovo team (“TBD Lab”) dedicato allo sviluppo di una superintelligenza. Oggi, infatti, il termine viene spesso usato come sinonimo o in alternativa ad AGI.

Vibe coding

La programmazione informatica è uno dei settori in cui l’avvento delle AI generative ha avuto l’impatto maggiore. Strumenti avanzati come Cursor e Claude Code consentono di automatizzare parti del lavoro, tanto da rendere possibile creare siti o applicazioni semplicemente descrivendoli al chatbot.

Nonostante i limiti e le allucinazioni del modello, i risultati sono spesso sorprendentemente funzionanti, tanto che Andrej Karpathy, esperto di intelligenza artificiale e co-fondatore di OpenAI, ha coniato l’espressione “vibe coding” per indicare un utilizzo delle AI per generare codice, accettando i risultati prodotti e riducendo al minimo l’intervento del programmatore. La promessa alla base del vibe coding è che anche chi non sa programmare può sviluppare semplici applicazioni e siti, semplicemente usando le AI.

– Leggi anche: Con l’intelligenza artificiale diventeremo tutti programmatori?