Il Congresso statunitense contro l’“amplificazione” dei social

Alcune proposte di legge stanno provando a definire le responsabilità nella diffusione tramite algoritmi dei contenuti «dannosi»

In un’attesa audizione del 1° dicembre scorso, la Commissione per l’energia e il commercio della Camera dei rappresentanti degli Stati Uniti ha discusso una serie di disegni di legge che mirano a privare le aziende tecnologiche proprietarie di social media dell’immunità legale di cui beneficiano per quanto riguarda le conseguenze dannose dei contenuti che diffondono sulle loro piattaforme raccomandandoli sulla base di procedimenti algoritmici: quelli che «amplificano», secondo l’espressione utilizzata dal Congresso.

È una discussione che si colloca nel noto e più ampio dibattito sulla complessa regolamentazione delle grandi aziende di Internet ma di cui negli Stati Uniti si sta parlando in particolare nelle ultime settimane perché è considerato un tentativo nuovo e più diretto di alcuni parlamentari americani, sia Repubblicani che Democratici, di attribuire delle responsabilità sostanziali a quelle aziende, di fatto privandole di uno “scudo legale” che è alla base di gran parte del funzionamento delle piattaforme di condivisione su Internet, non solo negli Stati Uniti ma anche nel resto del mondo.

Nello specifico, l’obiettivo del Congresso è quello di attribuire alle aziende di social media non una serie di responsabilità puntuali relative alla mancata moderazione di certi contenuti, bensì una responsabilità strutturale nell’incremento della diffusione (“amplificazione”) di contenuti di odio e disinformazione soggetti – come ogni altro contenuto – alle selezioni compiute sulla base di algoritmi che stabiliscono quali contenuti vedranno gli utenti e quando, meccanismi peraltro alla base dei modelli di business stessi di quelle aziende.

– Leggi anche: Il discusso libro sulle “brutte verità” di Facebook

Allo stesso tempo è piuttosto presente sui media, condivisa tra diversi osservatori ed esperti, l’impressione che si tratti di un dibattito complesso e articolato, privo di definizioni scontate su cosa sia l’amplificazione algoritmica e su quante e quali siano le correlazioni che è possibile istituire tra un determinato contenuto e le sue conseguenze dannose. Qualsiasi tentativo di intervenire sul funzionamento delle piattaforme potrebbe inoltre essere interpretato come una forma di limitazione e di censura in un contesto, quello americano, storicamente molto attento alle tutele della libertà di espressione su Internet.

Un manifestante indossa una maschera del CEO di Facebook Mark Zuckerberg a San Francisco, il 21 novembre 2020 (AP Photo/Jeff Chiu)

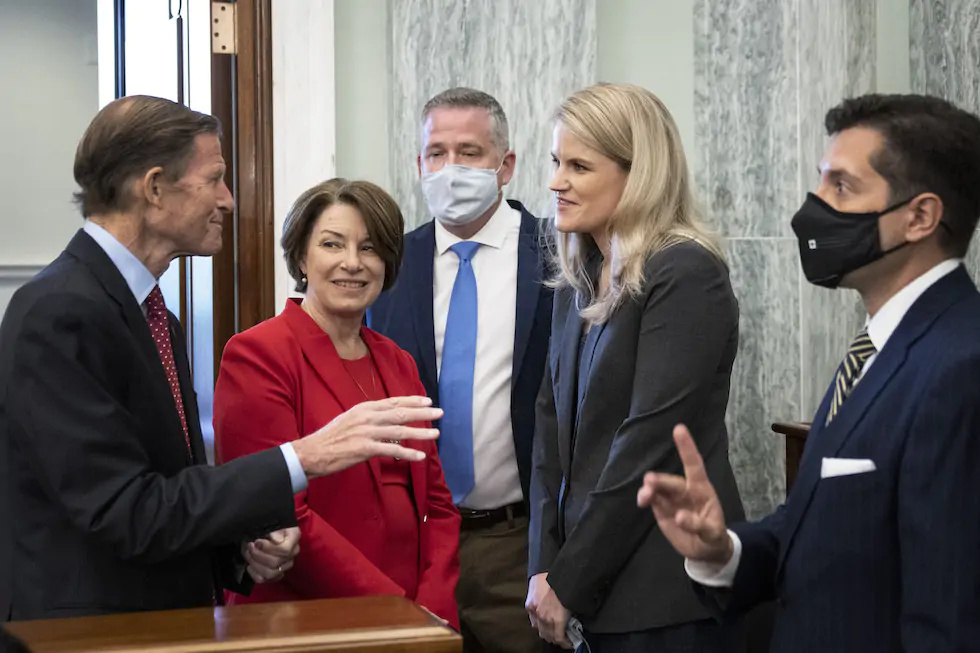

La discussione al Congresso – che si è avvalsa anche delle testimonianze rese dalla ex dipendente di Facebook e whistleblower Frances Haugen, responsabile della recente pubblicazione di una serie di documenti interni dell’azienda – si è concentrata sul tentativo specifico di modificare un comma di una legge del 1996, la Sezione 230 del Communications Decency Act, che garantisce alle aziende informatiche di non poter essere ritenute legalmente responsabili dei contenuti pubblicati dai loro utenti. Un comma spesso oggetto di critiche e discussioni nei dibattiti sulla libertà di espressione online.

Nessun fornitore di servizi internet e nessun utilizzatore di tali servizi può esser ritenuto responsabile quale editore o quale autore di una qualsiasi informazione che sia stata fornita da terzi.

I disegni di legge discussi dalla Commissione andrebbero a modificare in diversi punti la Sezione 230, in modo da renderla non applicabile ai casi in cui sia presente a monte una selezione operata attraverso algoritmi e che farebbe venir meno una presunta neutralità delle piattaforme di condivisione nella diffusione dei contenuti pubblicati da terzi. Ma è più facile a dirsi che a farsi, considerando che «gli algoritmi sono ovunque», come ha sintetizzato il New York Times descrivendo la complessità della materia. Per non parlare della difficoltà di connotare in questi termini uno strumento informatico tecnicamente così complesso.

Alcune delle leggi proposte prevedono una definizione molto ampia e generale dei termini della discussione e dei comportamenti che intendono regolamentare. In una legge proposta dal Democratico Tom Malinowski, deputato per lo stato del New Jersey, l’“amplificazione” di un contenuto è definita come un qualsiasi modo di «classificare, ordinare, promuovere, raccomandare, amplificare o alterare in modi analoghi la consegna o la visualizzazione delle informazioni».

– Leggi anche: Cosa c’è nei “Facebook Papers”

Un disegno di legge proposto dall’influente senatrice del Minnesota Amy Klobuchar, ex candidata alle primarie Democratiche del 2020, renderebbe una piattaforma legalmente responsabile nel caso in cui gli algoritmi «favorissero» la diffusione di disinformazione in materia di salute pubblica. Sarebbe ammessa come unica eccezione il caso in cui la piattaforma prevedesse una diffusione dei contenuti in modo «neutrale», per esempio attraverso una disposizione dei post in ordine cronologico.

Un’altra delle leggi proposte dai Democratici specifica che le piattaforme potrebbero essere citate in giudizio soltanto nel caso di «amplificazione» generata utilizzando i dati personali dell’utente, dati utilizzati dalle aziende per definire il bacino di utenza destinataria di un determinato contenuto. «Queste piattaforme non sono spettatrici passive: antepongono consapevolmente i profitti alle persone, e il nostro paese ne sta pagando le conseguenze», ha affermato il presidente della Commissione per l’energia e il commercio Frank Pallone.

Il disegno di legge proposto da Pallone prevede un’esenzione dalla responsabilità legale di “amplificazione” per le aziende di Internet con non più di 5 milioni di utenti mensili e nei casi di post visualizzati a fronte di una ricerca esplicita dell’utente (anche nel caso in cui i risultati siano poi ordinati attraverso un algoritmo). Sarebbe inoltre prevista un’esenzione per le società di servizi di hosting, quelle che materialmente ospitano i dati di un sito o di una app, rendendoli accessibili.

«La responsabilità è soltanto un mezzo per raggiungere un fine: l’obiettivo è incentivare le modifiche all’algoritmo», ha detto a Wired Malinowski, autore di una delle leggi proposte. Il punto della discussione, secondo lui, è che finché non ci saranno incentivi creati dall’introduzione della responsabilità legale delle grandi aziende tecnologiche sarà improbabile che quelle aziende apportino autonomamente cambiamenti al funzionamento delle loro piattaforme. «Saprebbero come migliorare le cose, se ci fosse una pressione sufficiente a farlo», ha detto Malinowski.

Il senatore Richard Blumenthal e la senatrice Amy Klobuchar parlano con la ex dipendente di Facebook e whistleblower Frances Haugen al Congresso, a Washington DC, il 5 ottobre 2021 (Drew Angerer/Getty Images)

La logica alla base della Sezione 230 della legge del 1996 è che gli utenti, e non le piattaforme che ospitano i contenuti, dovrebbero assumersi la responsabilità di ciò che dicono e fanno online. Ma all’epoca dell’approvazione della legge, chiarisce Wired, non erano ancora diffusi gli attuali sistemi di raccomandazione personalizzata dei contenuti sviluppati per aumentare al massimo il coinvolgimento (engagement). In sostanza, l’obiettivo dei disegni di legge è quello di fornire alle piattaforme una ragione per modificare i loro modelli di business, che sono oggi «sistemi ottimizzati per il coinvolgimento piuttosto che per la qualità» e che favoriscono «la diffusione di plagi, provocazioni e contenuti ingannevoli e faziosi che stimolano l’indignazione».

Sebbene le intenzioni alla base delle richieste di regolamentazione dei social media siano da tempo abbastanza chiare e più o meno generalmente condivise da un’estesa parte dell’opinione pubblica, esistono diversi problemi legati alla sostanziale assenza di definizioni coerenti, complete e univoche di molti termini della questione. A partire, per esempio, da cosa intendano i legislatori per contenuto «dannoso», ha scritto il New York Times. La Commissione ha fatto riferimento alle teorie del complotto, che possono portare i loro sostenitori a diventare violenti, o ai post di gruppi terroristici, che possono indurre i loro seguaci a compiere attacchi. Nella maggior parte dei casi si tratta comunque di riferimenti molto specifici.

Il disegno di legge avanzato da Klobuchar cita la «disinformazione sanitaria» nella definizione di contenuto dannoso, ma lascia al Dipartimento della salute degli Stati Uniti il compito di determinare cosa sia esattamente disinformazione sanitaria e cosa no. La legge proposta da Pallone, il presidente della Commissione, inquadra invece i contenuti dannosi come qualsiasi post che «contribuisca materialmente a un grave danno fisico o emotivo a una qualsiasi persona», che è un criterio problematico. Il disagio emotivo richiederebbe di essere accompagnato da sintomi fisici, scrive il New York Times, ma potrebbe anche riguardare, per esempio, un’adolescente la cui autostima sia diminuita in seguito all’uso di Instagram al punto da indurre quella persona all’autolesionismo.

– Leggi anche: Gli effetti di Instagram sui più giovani

Alcuni membri Repubblicani del Congresso hanno inoltre espresso preoccupazione in merito alle proposte di modifica della Sezione 230, sostenendo che in caso di approvazione una legge di questo tipo finirebbe soltanto per indurre le piattaforme a rimuovere contenuti che dovrebbero rimanere attivi. «È un tentativo sottilmente velato di fare pressione sulle aziende affinché censurino più discorsi», ha detto la rappresentante per lo stato di Washington e capogruppo dei repubblicani alla Camera Cathy McMorris Rodgers.

Esistono infine una serie di perplessità riguardo alle possibili conseguenze indirette delle leggi eventualmente approvate in materia di responsabilità legale delle piattaforme. La stessa Haugen, durante l’udienza al Senato, ha fatto riferimento alle ripercussioni sulle persone più vulnerabili determinate da una lieve modifica della Sezione 230 approvata dal Congresso nel 2018, che rimosse l’immunità delle aziende nel caso in cui le piattaforme facilitino consapevolmente il traffico sessuale. Alcuni sex worker affermarono in seguito che quel cambiamento li aveva esposti a maggiori rischi rendendo più difficile e in alcuni casi impossibile l’utilizzo delle piattaforme per ottenere maggiori informazioni sui clienti.

Anche a prescindere da questi rischi, in generale, il tentativo di riforma della Sezione 230 potrebbe dover affrontare una serie di difficoltà difficili da superare, secondo molti osservatori. È ritenuto improbabile, prima di tutto, che le Corti statunitensi accolgano favorevolmente questo tipo di espedienti costituzionali. Un disegno di legge che privasse le aziende delle protezioni garantite loro dalla Sezione 230 – soltanto sulla base del fatto che quelle aziende utilizzano algoritmi per incrementare la diffusione di determinati contenuti a scapito di altri – potrebbe finire per sembrare una sorta di abrogazione de facto di quella parte della legge del 1996 per le piattaforme di social media che ospitano e “raccomandano” contenuti generati dagli utenti.

A quel punto, come sottolinea il giurista e docente di sicurezza informatica Jeff Kosseff, autore del libro The Twenty-Six Words That Created the Internet, alle aziende di Internet resterebbero diversi modi per tentare di ottenere tutela legale, incluso il ricorso al primo emendamento della Costituzione americana, che vieta al Congresso di emanare leggi per limitare la libertà di parola o di stampa. «Costruire un algoritmo efficace è complicato. Così come lo è scrivere una buona legge», osserva Wired.

Secondo il Washington Post, i legislatori hanno ragione quando individuano negli algoritmi e nei modelli di apprendimento automatico gli strumenti che determinano il funzionamento delle piattaforme, ossia che stabiliscono chi-vede-cosa. Ma sbagliano a credere che concentrarsi sull’«amplificazione algoritmica» – anziché, come tentato in passato, sul merito o su specifiche tematiche dei discorsi online, riguardo ai quali eventualmente sospendere l’immunità delle piattaforme – sia una via più semplice per regolamentare i social media.

Una sospensione delle protezioni dovuta alla presenza di un’amplificazione algoritmica, innanzitutto, non impedirebbe di per sé la pubblicazione di contenuti comunque dannosi su piattaforme prive di raccomandazioni o personalizzazioni dei contenuti basate su algoritmi. I critici di Facebook e di altri social media sperano che questa sospensione della Sezione 230 possa sostanzialmente cambiare il tipo di contenuti iper-diffusi sulle piattaforme, e magari porre fine del tutto al fenomeno dell’“amplificazione”.

Ma per quanto allettante possa sembrare in un mondo afflitto dalla disinformazione virale, scrive il Washington Post, questo cambiamento potrebbe rivelarsi pericoloso. La possibilità delle aziende di Internet di ordinare i contenuti porta spesso a favorire quelli sensazionalistici, ma può anche permettere loro di assegnare priorità a informazioni di qualità o rendere l’utilizzo della piattaforma più comodo e divertente.

«Un Facebook in cui tutti i post sono ordinati cronologicamente potrebbe essere un Facebook meno coinvolgente (per non parlare dello spam). Una Internet in cui tutto è ordinato cronologicamente sarebbe praticamente inutilizzabile», conclude il Washington Post.