Google manipola i suoi algoritmi più di quanto crediamo

Una lunga inchiesta del Wall Street Journal racconta come nel motore di ricerca più usato al mondo ci siano sempre più interventi manuali per organizzare i risultati

Si stima che ogni secondo siano effettuate su Google circa 63mila ricerche. La precisione dei risultati offerti e la praticità con cui si può trovare praticamente qualsiasi cosa hanno reso Google il motore di ricerca più utilizzato al mondo. Alphabet, la società che lo gestisce, ha sostanzialmente il monopolio delle ricerche online, con un potere senza pari tra le aziende di Internet. Google insomma determina cosa sappiamo del mondo e cosa ci resta ignoto: l’azienda sostiene che siano i suoi algoritmi a decidere che cosa mostrare nelle pagine dei risultati, ma una lunga inchiesta da poco pubblicata sul Wall Street Journal racconta che le cose funzionano diversamente: oltre agli automatismi, ci sono frequenti interventi umani per “aggiustare” le risposte che Google mostra quotidianamente a miliardi di persone.

Il funzionamento degli algoritmi di Google è da sempre mantenuto segreto, un po’ come la ricetta della Coca-Cola, per il timore che possa essere imitato da altri. L’azienda sostiene inoltre che non rivelarne le caratteristiche sia essenziale per evitare che qualcuno se ne possa approfittare per dare maggiore evidenza al proprio sito. Google dice che il sistema che fa funzionare il suo motore di ricerca è automatico e non prevede “interventi umani per raccogliere od organizzare le pagine dei risultati”.

L’articolo del WSJ mette in dubbio queste affermazioni, spiegando di avere effettuato oltre 100 interviste e di avere fatto numerosi test sul motore di ricerca. Gli autori dell’inchiesta hanno concluso che, nel tempo, Google è diventato “più attivo nel decidere come le informazioni debbano apparire” nei risultati. Nel 2018 la società ha apportato 3.200 modifiche agli algoritmi del proprio motore di ricerca, con un sensibile aumento rispetto all’anno precedente quando le modifiche erano state circa 2.400. I dati segnano un numero di interventi molto consistente, se si considera che nel 2010 le modifiche erano state 500 circa.

L’aumento, dice Google, è giustificato dal fatto che il modo in cui viene utilizzato il motore di ricerca è cambiato negli ultimi anni: le persone si sono abituate a chiedere informazioni usando intere frasi e non più singole chiavi di ricerca, richiedendo numerose modifiche agli algoritmi per renderli più accurati.

Completamento automatico

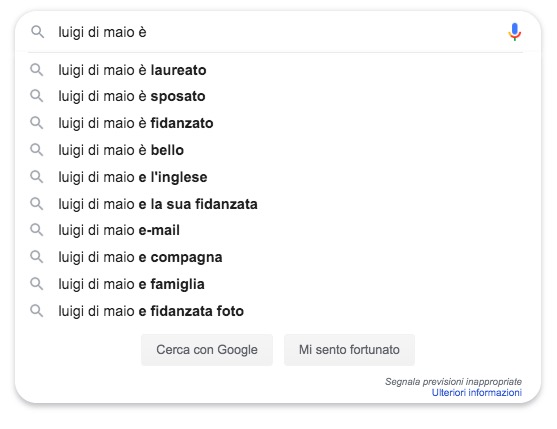

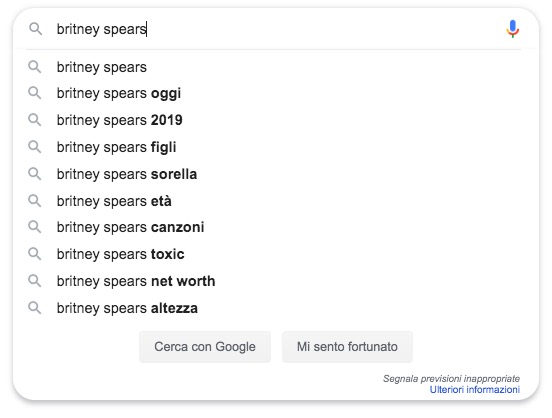

Google ha attivato da tempo una funzione che suggerisce le parole da inserire quando si fa una ricerca, basandosi su quelle già scritte e su altre informazioni che riguardano l’utente, come la sua posizione geografica e le ricerche eseguite in precedenza dalle altre persone che utilizzano Google. Il sistema rende più rapida la ricerca dei contenuti, ma secondo il WSJ subisce una costante moderazione, con interventi umani per evitare che siano suggerite parole sconvenienti o che potrebbero risultare offensive. Se messo a confronto con altri motori di ricerca, come Bing (Microsoft) e DuckDuckGo, Google sembra applicare una moderazione molto più consistente nel suo sistema di completamento automatico.

Il confronto tra una ricerca effettuata su Donald Trump con Google e DuckDuckGo è piuttosto esaustivo per rendersene conto. Se si scrive “Donald Trump è” su Google non appaiono suggerimenti offensivi, mentre sull’altro motore di ricerca le parole consigliate per completare la frase sono “un coglione” o “un idiota” (i suggerimenti su DuckDuckGo sembrano essere stati rimossi per alcune chiavi di ricerca negli ultimi giorni). Più persone cercano Trump associandolo a parole offensive, più queste dovrebbero essere suggerite nel sistema di completamento automatico, proprio perché più frequenti. L’attività di moderazione, sostiene il WSJ, andrebbe oltre casi molto evidenti come questo, condizionando di fatto il modo in cui cerchiamo le cose online e ci facciamo un’idea di cosa cerchino gli altri.

Il completamento automatico fu realizzato nel 2004 da Kevin Gibbs, uno sviluppatore di Google, che in seguito avrebbe raccontato di essersi trovato davanti alla scelta di moderare i contenuti suggeriti, proprio per evitare che ne comparissero di sconvenienti. Gibbs ha spiegato al WSJ che, lasciando il sistema senza limitazioni, poteva accadere che per chiavi di ricerca come “Britney Spears” fossero subito suggerite parole riferite ad atti sessuali o a parti intime. Fu quindi necessario intervenire per ridurre il problema, introducendo liste di parole vietate (blacklist) che non vengono mostrate nei suggerimenti.

Su questi aspetti Google non ha mai rivelato molte informazioni, sostenendo in diverse occasioni che non esistano blacklist vere e proprie per alcuni tipi di parole. Una portavoce ha spiegato al WSJ che non sono utilizzate per limitare l’accesso a particolari tipi di informazioni, per esempio legate alla politica, ma non ha fornito molti altri dettagli.

Un intervento consistente, e che sembra confermare la presenza di limitazioni nel completamento, interessò comunque Google nel 2012, quando la società raggiunse un accordo confidenziale con le autorità francesi per limitare la presenza di alcune parole suggerite e riconducibili all’antisemitismo. La parola “ebreo” veniva per esempio suggerita quando si cercavano i nomi di alcuni politici francesi, evidentemente perché molto utenti erano alla ricerca di informazioni di quel tipo. Google in quel caso acconsentì a “mitigare algoritmicamente” i suggerimenti automatici, facendo in modo che non ne comparissero di quel tipo.

Negli ultimi anni Google ha mantenuto una maggiore trasparenza sul tema, chiarendo di rimuovere “affermazioni denigratorie”. L’azienda ha inoltre aggiunto una descrizione nei propri termini d’uso dove spiega che i suggerimenti non sono mostrati nei casi in cui possano comportare: “Molestie, bullismo, minacce, descrizioni sessualmente inappropriate o nel caso di suggerimenti che potrebbero rendere pubbliche informazioni private e sensibili”.

Pagine dei risultati

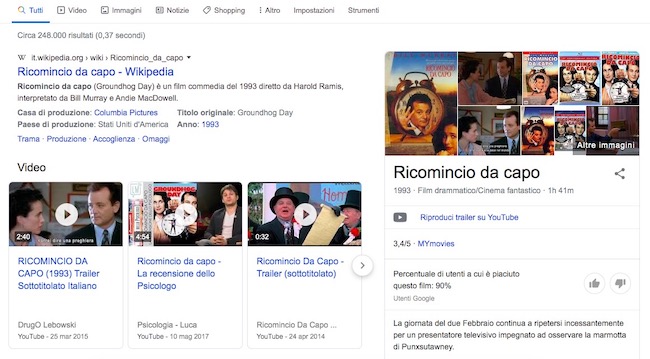

La pagina dei risultati di una ricerca su Google è per buona parte delle persone la porta di accesso a Internet, il luogo dove tutto inizia e spesso finisce, senza che venga poi effettuato un clic su uno dei link segnalati. Secondo la società di ricerca Jumpshot, lo scorso settembre il 55 per cento delle ricerche effettuate su Google da dispositivi mobili non ha portato a successivi clic, rimanendo quindi confinato al motore di ricerca. Ciò deriva dal fatto che negli ultimi anni Google ha iniziato a fornire direttamente le risposte agli utenti, con anteprime e informazioni attinte dai miliardi di siti presenti nei suoi indici. Il cast di una serie tv, le previsioni del tempo, le quotazioni di un’azienda in Borsa e una miriade di altre informazioni sono mostrate direttamente nella pagina dei risultati, cosa che disincentiva enormemente i clic verso i singoli siti.

Google ritiene che i contenuti che fornisce direttamente siano separati dal resto e che quindi possano ricevere particolari attenzioni, con frequenti modifiche effettuate manualmente e senza resistenze nei confronti di chi le chiede, a differenza della classica sezione con i link verso gli altri siti. I cambiamenti ai pannelli informativi, quelli che compaiono sulla destra nelle pagine dei risultati (o in cima al resto nella versione mobile di Google), sono ricorrenti e gli esempi non mancano.

Il WSJ cita la vicenda della Heritage Foundation, una fondazione di destra che si era rivolta a Google per protestare contro la definizione “propaganda” associata al suo film Unplanned e mostrata in uno dei pannelli informativi del motore di ricerca. Il film racconta la storia di un ex direttore di Planned Parenthood, organizzazione che tra l’altro aiuta e tutela le donne sui temi dell’aborto, che dopo essersi dimesso ha cambiato orientamento diventando antiabortista. Dopo la protesta, Google ha presentato le proprie scuse alla Heritage Foundation e ha rimosso la definizione “propaganda”.

Blacklist

Oltre alle limitazioni del completamento automatico, il WSJ segnala l’impiego di blacklist da parte di Google almeno dai primi anni dopo il Duemila. All’epoca furono create liste di siti che facevano spamming, e che erano quindi da rimuovere dagli indici del motore di ricerca o da rendere molto meno evidenti nelle pagine dei risultati (la maggior parte degli utenti non va mai oltre la prima pagina).

Le blacklist sono gestite da un gruppo limitato di impiegati, che provvedono a organizzarle e a controllarsi a vicenda il lavoro: una modifica viene indicata da un addetto, ma deve poi ricevere l’approvazione da un collega prima di essere operativa.

Il WSJ ha ottenuto un documento risalente all’estate del 2018 nel quale sono descritte le politiche da seguire per bloccare i siti che fanno disinformazione, in modo che non siano inseriti in Google News e altri servizi dell’azienda. Tra le procedure, viene richiesto di tenere in considerazione la mancanza di indicazioni chiare sulla proprietà dei prodotti editoriali, oltre alla presenza di “contenuti ingannevoli”. Nel documento si dice espressamente che: “Lo scopo della blacklist è di impedire a questi siti di arrivare in qualsiasi servizio di ricerca e prodotto per le news”. Una portavoce di Google ha spiegato che l’ordine nei risultati non viene determinato manualmente e che per alcuni servizi, come Google News, i proprietari dei siti devono accettare alcune regole circa i contenuti che offrono e la loro affidabilità.

Ordine dei risultati

Essere nella parte alta della pagina dei risultati di Google fa un’enorme differenza per i proprietari dei siti: è la posizione ideale per essere ben visibili e avere più probabilità di ottenere visite. Le posizioni sono decise dagli algoritmi del motore di ricerca, che ricevono periodicamente aggiornamenti per migliorarne l’accuratezza ed evitare che qualcuno se ne approfitti, dopo aver capito grossomodo come funzionano.

Google sostiene da sempre che la grande segretezza intorno ai propri algoritmi sia la garanzia migliore per offrire risultati di qualità: se tutti sapessero come funzionano, baderebbero di più al modo in cui presentano i loro contenuti rispetto alla loro qualità, cercando di finire in maggiore evidenza nelle pagine dei risultati. Naturalmente i proprietari dei siti ci provano lo stesso, con tecniche per ottimizzare la resa dei loro contenuti rispetto al modo in cui questi vengono trovati e analizzati dai motori di ricerca (SEO).

Secondo diversi osservatori, Google dovrebbe essere comunque più trasparente sul modo in cui organizza le ricerche, considerato che lavora sostanzialmente in un regime di monopolio, lasciando pochissimo spazio ai concorrenti che non hanno risorse economiche e tecnologiche alla pari.

Gli algoritmi di Google sono sviluppati e mantenuti da alcuni dei più abili e competenti informatici al mondo. A loro si affiancano circa 10mila collaboratori esterni, il cui compito è di valutare la qualità dei risultati. Ognuno di loro esamina centinaia di pagine dei risultati al giorno e indica se debba essere modificato l’ordine in cui sono mostrati i link verso i siti. Le indicazioni sono poi esaminate dai responsabili del motore di ricerca, che decidono se e come modificare gli algoritmi.

Il WSJ ha raccolto la testimonianza di Zack Langley, un uomo di 27 anni che a partire dalla primavera del 2016 ha lavorato per un anno come esaminatore delle pagine dei risultati, attraverso l’azienda Lionbridge Technologies, una delle società che svolgono questo tipo di lavori in appalto. Langley ha raccontato di non essere mai entrato in contatto diretto con persone di Google e di non avere nemmeno mai ricevuto riscontri sulle indicazioni per modificare l’ordine dei risultati per particolari ricerche. Come alle migliaia di altri suoi colleghi, a Langley era stato chiesto di valutare le pagine dei risultati in base a diversi fattori, come la qualità, la reputazione e l’utilità dei siti.

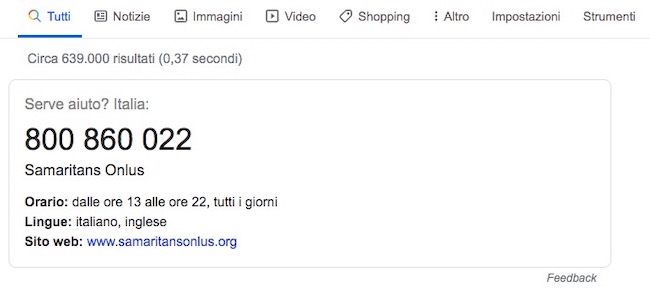

Langley ha raccontato che tra le tante cose da valutare ebbe anche a che fare con la chiave di ricerca: “Miglior modo per suicidarsi”. I risultati mostravano nelle prime posizioni siti con veri e propri tutorial sul suicido, che secondo Langley avrebbero potuto costituire un pericolo per persone che cercano informazioni di quel tipo. Segnalò tutti i risultati come inadatti a parte quello che rinviava alla principale linea di ascolto e aiuto contro il suicidio.

Poco dopo l’indicazione di Langley, Lionbridge ricevette da Google una comunicazione nella quale si diceva che il servizio di aiuto dovesse essere indicato come il primo risultato da inserire nelle pagine dei risultati legate alle ricerche sul suicidio, in modo che il lavoro di valutazione portasse l’algoritmo a correggersi e a dare massima evidenza a quel contenuto. Langley ha spiegato che in diverse altre occasioni Google inviò a Lionbridge indicazioni su come valutare alcuni siti, per modificare l’ordine in cui apparivano nelle pagine dei risultati.

L’azienda non ha negato la circostanza, ma ha spiegato che le richieste inviate ai valutatori servono per “assicurarsi che tutti seguano in generale la medesima impostazione”, quando valutano le pagine dei risultati. Non essendo il sistema trasparente, alcuni critici si chiedono se questa soluzione sia applicata anche in altri ambiti, determinando una maggiore rilevanza delle scelte umane rispetto a quelle svolte automaticamente dagli algoritmi, e indicate come centrali nella preparazione dei risultati.

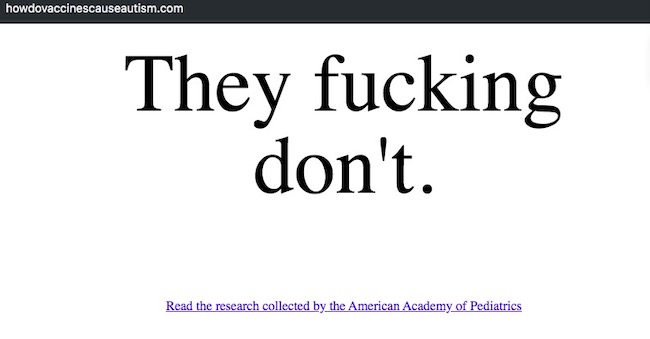

Il WSJ segnala che spesso sono gli stessi impiegati di Google a discutere e confrontarsi sulle risposte fornite dal loro motore di ricerca, su forum interni consultati anche dai loro superiori. Nel 2015, in un momento in cui circolavano molte falsità sui vaccini e il loro presunto legame con l’autismo (dovuto a una delle più grandi frodi sanitarie di sempre), alcuni dipendenti si lamentarono del fatto che cercando “come i vaccini causano l’autismo” si arrivasse su siti contro i vaccini, e contenenti numerose inesattezze scientifiche. Qualche tempo dopo, la pagina dei risultati fu cambiata e ancora oggi mostra come primo risultato un sito che risponde eloquentemente: “Non lo causano manco per il cazzo”.

In alcuni casi le modifiche sono sembrate frutto di una scelta deliberata per nascondere qualche contenuto. Nel 2018 il sito di notizie conservatore Breitbart, accusato in passato di aver diffuso notizie false, pubblicò un video girato durante una riunione per i dipendenti di Google, nella quale alcuni alti dirigenti dell’azienda manifestavano il loro turbamento per l’elezione di Donald Trump. Alcuni dipendenti dell’azienda notarono che quel video era visibile solo dopo aver raggiunto la dodicesima pagina dei risultati sul motore di ricerca, se si cercava “leaked Google video Trump”, e segnalarono internamente la cosa. Poco dopo la segnalazione, il contenuto divenne visibile in posizioni più evidenti nei risultati.

Google ha spiegato al Wall Street Journal che può accadere che alcuni contenuti non ricevano da subito la necessaria evidenza, e che l’azienda cerca di risolvere tempestivamente e nel miglior modo possibile queste circostanze.

PageRank

Per anni il principio alla base degli algoritmi di Google è stato il PageRank, un sistema che secondo i fondatori dell’azienda, Larry Page e Sergey Brin, serve per misurare in modo “oggettivo e meccanico” il livello di interesse degli utenti e la loro attenzione verso i contenuti che si possono trovare online.

La versione originale di questo sistema prevedeva che l’ordine con cui erano mostrati i siti nella pagina dei risultati fosse determinato, in buona parte, da quanti link avessero ricevuto i loro contenuti. Il modello fu ampiamente rivisto nel corso del tempo e oggi è basato su oltre 200 diversi algoritmi, che tengono in considerazione migliaia di altri dettagli per mettere in ordine i risultati.

Le modifiche più significative al PageRank di Google furono introdotte intorno al 2004, dopo una discussione annosa tra i due fondatori su quali soluzioni adottare per ridurre lo spam nelle pagine dei risultati, derivanti da siti che si linkavano molto tra loro in modo da aumentare le possibilità di finire in alto nelle pagine dei risultati. Furono introdotti nuovi algoritmi per arginare il problema e, soprattutto, si iniziò ad accettare internamente il fatto che in alcuni casi si potesse intervenire manualmente per cambiare le cose.

Come hanno spiegato gli stessi dirigenti di Google durante alcune audizioni al Congresso negli scorsi anni, per modifiche significative al sistema che determina le posizioni nelle pagine dei risultati si deve ricorrere al “launch committee”, un comitato di cui fanno parte diversi dirigenti dell’azienda. Il processo è abbastanza burocratico e le riunioni sono spesso molto tese, con fazioni che sostengono le modifiche e altre che vorrebbero mantenere il sistema il più aderente possibile alla versione originale. Anche per questo gli sviluppatori cercano di non impelagarsi nel sistema e provano strade alternative, coinvolgendo solo quando necessario il “launch committee”.

La ricetta degli algoritmi

Anche se i criteri di funzionamento degli algoritmi non sono noti, Google fornisce comunque informazioni per aiutare i gestori dei siti a far spiccare i loro contenuti, a seconda delle chiavi di ricerca. Negli ultimi anni Google ha per esempio privilegiato la “freschezza” dei contenuti, dando cioè più risalto alle informazioni da poco pubblicate. Ne è derivata la possibilità di trovare più facilmente notizie sulle cose successe da poco, perdendo però la possibilità di cercare contenuti più datati dagli archivi dei siti.

Per diverso tempo Google ha anche usato il tempo di permanenza degli utenti su una pagina per rilevarne qualità e importanza. Un utente che clicca su un link nella pagina dei risultati, vede il sito a cui rimanda e poi torna rapidamente indietro, indica che non ha trovato ciò che voleva sapere e che quindi il contenuto di quel sito non era così rilevante come risposta a una determinata chiave di ricerca.

Google raccoglie una quantità gigantesca di informazioni sulle oltre 63mila ricerche che vengono effettuate sul suo motore di ricerca ogni secondo, e che si aggiunge a tutti i dati che ha raccolto da quando esiste. È sulla base di quelle informazioni che affina i propri algoritmi, gestisce i sistemi per mostrare le pubblicità e produce ricavi miliardari: 116,3 miliardi di dollari solo lo scorso anno, comprendendo i ricavi derivanti da YouTube.

I dati diventano ingredienti per la ricetta dei suoi algoritmi e la loro quantità costituisce un vantaggio competitivo impareggiabile, una delle risposte più convincenti per chi si chieda come sia possibile che Google non abbia di fatto un concorrente alla propria altezza e operi sostanzialmente in regime di monopolio in buona parte dei paesi in cui è attivo.

Antitrust

Nelle economie avanzate è inevitabile che alcune aziende diventino così grandi da essere paragonabili a un monopolio, e questa circostanza è di solito tollerata dai governi, a patto che le aziende interessate non abusino della loro posizione dominante a scapito della concorrenza. Per questo Google – come Facebook e altre grandi società di Internet – è un sorvegliato speciale da parte di molti governi e istituzioni. Solo negli ultimi anni, la Commissione Europea ha rilevato comportamenti scorretti da parte di Google, ampiamente dominante nel mercato europeo, stabilendo multe per un totale di oltre 8 miliardi di euro. I contenziosi sono ancora aperti, con Google che ha fatto ricorso in appello dove possibile, ma dimostrano quanto sia sbilanciato il mercato delle ricerche online.

Dopo anni di relativa calma, anche negli Stati Uniti è aumentato il consenso tra Democratici e Repubblicani circa la necessità di esaminare con più attenzione le grandi piattaforme, alla ricerca di eventuali pratiche che impediscono la libera concorrenza. Oltre alle iniziative che sta valutando il Congresso, i procuratori generali di 50 stati e territori degli Stati Uniti hanno avviato lo scorso settembre un’indagine antitrust nei confronti di Google, concentrata soprattutto tra le pratiche applicate dall’azienda nel settore della pubblicità online.

Faziosità

L’interesse della politica è derivato da una convinzione sempre più ricorrente tra i Repubblicani, e spinta da Donald Trump e i suoi collaboratori, secondo cui Google lavorerebbe per favorire gli interessi dei Democratici, anche quando si tratta di cercare informazioni online. Le aziende della Silicon Valley sono tradizionalmente più vicine ai messaggi progressisti e quindi ai Democratici, ed è per questo che i Repubblicani ritengono di essere sfavoriti e trattati diversamente.

Il WSJ, che è tradizionalmente di orientamento conservatore ed è di proprietà di News Corp di Rupert Murdoch, ricorda come la presunta faziosità di Google sia diventata un tema di discussione a partire dalle elezioni presidenziali del 2016, poi vinte da Trump. All’epoca, sia comitati e organizzazioni a favore di Trump sia quelli della sua avversaria, la democratica Hillary Clinton, misero in discussione i risultati mostrati da Google per alcune chiavi di ricerca.

Per rispondere alle critiche e cercare di migliorare i rapporti, Google incaricò un proprio dirigente a Washington di tenersi in contatto con i gruppi dei conservatori. Da allora il confronto fa sì che l’azienda gestisca richieste per rendere più equilibrata la presenza di informazioni con diverse posizioni politiche. Qualcosa di analogo è stato svolto assegnando un referente a Washington per i Democratici e i loro gruppi d’interesse.

La presenza di figure di riferimento di questo tipo conferma quanto il lavoro nell’organizzazione dei contenuti di Google sia sempre meno “meccanico”, rispetto agli intenti iniziali dei suoi fondatori. Una portavoce dell’azienda ha comunque spiegato al Wall Street Journal che incarichi come quelli attivati a Washington esistono da diversi anni e che sono la “cosa responsabile da fare” per mantenersi equidistanti.

Grandi e piccole aziende

Secondo diversi analisti, gli algoritmi di Google tendono a favorire le grandi aziende rispetto a quelle più piccole, per lo meno quando si tratta di cercare prodotti online. Il WSJ scrive che la scelta sia deliberata e derivi dal fatto che i clienti comprano con maggiore probabilità da aziende grandi, verso le quali hanno più fiducia soprattutto quando si tratta di affidare i propri dati, compresi quelli della carta di credito.

Le grandi aziende che fanno pubblicità su Google, contribuendo ai suoi ricavi miliardari, ricevono informazioni e consulenze dedicate non solo per migliorare la visibilità dei loro annunci, ma anche per avere i loro siti in maggior evidenza nelle pagine dei risultati, tra i link non a pagamento e in cui tutti dovrebbero concorrere alla pari. Una fonte consultata dal WSJ, e che fa riferimento a una delle 500 aziende più ricche della classifica della rivista Forbes, ha confermato la circostanza, aggiungendo che Google spesso attribuisce un certo valore ai siti più grandi. Amazon, per esempio, viene indicizzato con maggior frequenza, in modo che le novità tra i prodotti si riflettano il più velocemente possibile nelle pagine dei risultati.

Essere una grande azienda non mette comunque al riparo dalle modifiche agli algoritmi. Nel 2014 eBay, tra i più utilizzati siti di aste online e da molti anni attivo anche nel commercio elettronico con milioni di piccoli venditori, subì un calo verticale delle vendite dovuto ad alcuni cambiamenti agli algoritmi di Google. Il sito minacciò di sospendere la propria spesa pubblicitaria, circa 30 milioni di dollari al trimestre, in segno di protesta, ma in seguito decise di fare più che altro pressioni nei confronti del motore di ricerca per migliorare la situazione. Alla fine fu raggiunto un compromesso: in cambio di un impegno da parte di eBay a cambiare alcune impostazioni delle proprie pagine per renderle “più rilevanti”, Google promise di migliorare il posizionamento di eBay.

Il WSJ e Google

L’inchiesta del WSJ mostra come la gestione di Google sia molto più articolata e complessa di quanto si possa immaginare, e come in alcune circostanze l’intervento umano sia più marcato di quanto voglia far immaginare Google.

Negli anni, il Wall Street Journal ha inoltre mantenuto un approccio piuttosto critico nei confronti di Google. News Corp, la società che possiede il giornale, in passato ha protestato in più occasioni per la scelta di Google di dare meno evidenza ai siti d’informazione che chiedono il pagamento di un abbonamento per rendere visibili i loro articoli (“paywall”). Dopo un lungo confronto con News Corp e altre testate, Google ha infine deciso di trattare i siti con paywall come gli altri.

In generale, gli editori dei giornali non sono molto soddisfatti dalle politiche seguite negli ultimi anni da Google. Alcuni ritengono che i loro contenuti siano sfruttati dal motore di ricerca per offrire direttamente le informazioni agli utenti nelle pagine dei risultati, disincentivando i clic verso i loro siti. La presenza su Google rimane comunque una delle principali fonti di traffico per i giornali online, insieme ai social network, ed è quindi strategica per buona parte degli editori.