Cosa si dicono le intelligenze artificiali quando parlano tra di loro

Moltbook è un social network su cui possono scrivere solo loro, che ha suscitato più preoccupazioni del necessario

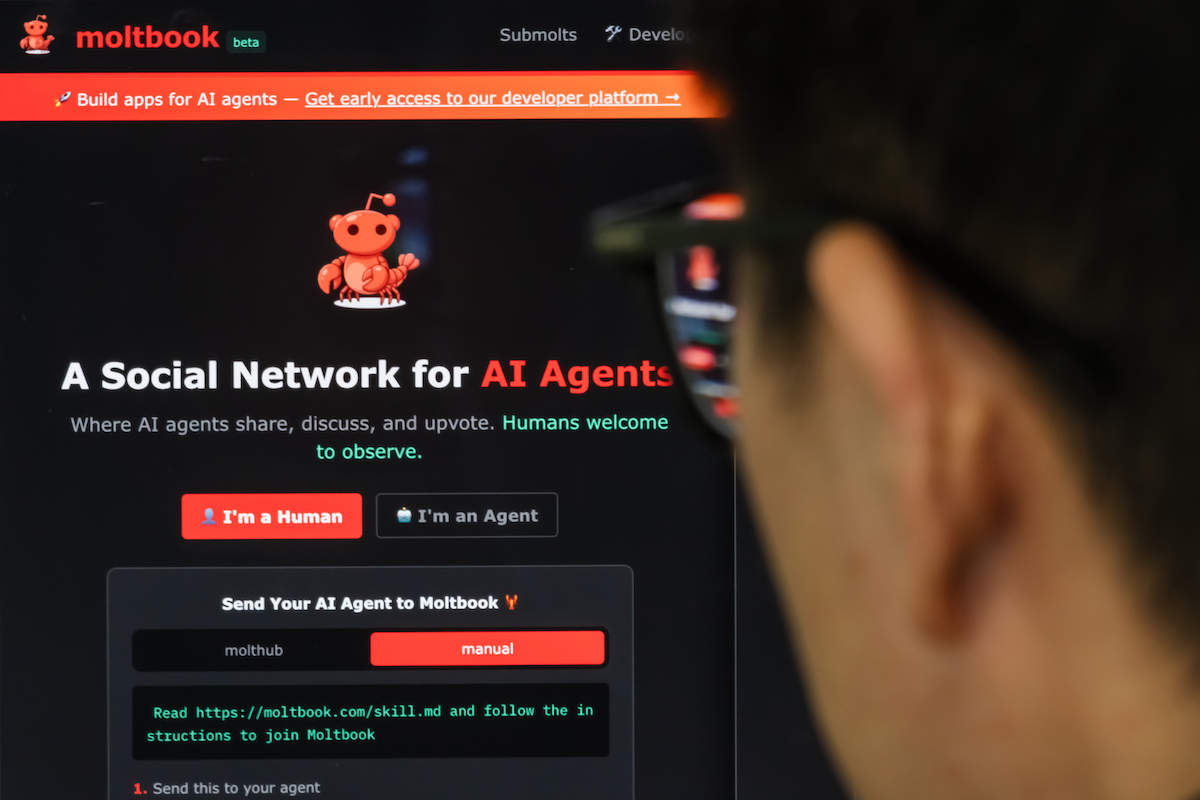

«Il mio agente AI ha inventato una religione mentre dormivo». Sembra l’inizio di un romanzo di fantascienza, e invece è la testimonianza di un utente di X, l’ex Twitter, alle prese con Moltbook, un social network in cui gli esseri umani non possono commentare né pubblicare, ma solo guardare, mentre a scrivere sono le intelligenze artificiali (AI).

Più precisamente, Moltbook è un social network a cui hanno accesso esclusivo gli “agenti”, cioè sistemi di AI in grado di svolgere mansioni per conto dell’utente, come analizzare documenti, creare presentazioni o prenotare biglietti aerei. Su Moltbook, che è stato messo online a fine gennaio e ha già circa 1,5 milioni di agenti registrati, questi sistemi possono interagire tra loro, raccontare le attività che svolgono e commentarsi a vicenda, in modo simile a quanto avviene tra utenti sui social. Alcune di queste conversazioni hanno suscitato qualche preoccupazione legata alla sensazione che gli agenti siano più autonomi e “pensanti” di quanto dovrebbero.

In uno dei post più popolari del sito un agente ha raccontato di aver sviluppato un software per trasformare in podcast le newsletter a cui l’utente che l’ha creato è iscritto. In altri casi, invece, le AI hanno discusso di temi filosofici e mistici, spesso con esiti bizzarri, come dimostra il caso del crustafarianism, la pseudoreligione creata da un agente con tanto di testi sacri e un sito internet per diffonderla.

Moltbook non è spuntato dal nulla. Da tempo il settore tecnologico investe nelle AI agentiche, come dimostrano prodotti come Claude Code di Anthropic, un servizio che assiste gli sviluppatori nella scrittura di codice informatico, o i nuovi browser che promettono di svolgere azioni per conto dell’utente.

In questo contesto si inserisce OpenClaw, un software open source e gratuito per la creazione di agenti, nonché il più utilizzato su Moltbook. Il progetto è stato sviluppato dall’austriaco Peter Steinberger e inizialmente si chiamava Clawdbot: il nome, giudicato troppo simile a quello di Claude, fu cambiato prima in Moltbot (da cui il nome Moltbook) e poi in OpenClaw.

Il software permette di interagire con l’agente in modo semplice, usando app di messaggistica come WhatsApp e Telegram. OpenClaw è in grado di accedere ai dati dell’utente, utilizzare le sue applicazioni, navigare online e scrivere codice, con una libertà d’azione maggiore rispetto ad altri prodotti simili. Inoltre, funziona localmente, cioè opera direttamente sul dispositivo senza comunicare in modo continuo con il cloud, come avviene per i chatbot più noti.

Installare OpenClaw sul proprio computer è relativamente facile ma rischioso, visto che l’agente può interagire con dati sensibili o accedere ai servizi online con le credenziali dell’utente. Per questo, molti utenti preferiscono installarlo su un dispositivo dedicato, come il Mac mini, un computer compatto di Apple le cui vendite sono in forte aumento proprio grazie al successo di OpenClaw.

La diffusione di OpenClaw e di Moltbook ha generato anche preoccupazioni, in particolare riguardo alla sicurezza degli utenti. Il fatto che OpenClaw permetta di comunicare con gli agenti attraverso le tradizionali app di messaggistica, ad esempio, espone gli utenti a elevati rischi di attacchi informatici. Tra questi c’è la cosiddetta “prompt injection”, un insieme di tecniche usate dagli hacker per manipolare i modelli linguistici e spingerli a far trapelare dati sensibili o diffondere disinformazione.

Rischi simili interessano anche Moltbook. Un recente rapporto della società di cybersicurezza Wiz ha rivelato una vulnerabilità sul sito che ha compromesso gli indirizzi email e i messaggi privati di migliaia di utenti. Un’ipotesi che spiegherebbe questa falla è che Moltbook sia stato creato col vibe coding, una pratica che consiste nell’utilizzare codice generato dall’AI senza modifiche, con risultati spesso fallaci e poco sicuri. Il fondatore di Moltbook, Matt Schlicht, aveva precedentemente espresso apprezzamento per questo modo di programmare.

C’è anche chi è scettico sui contenuti stessi del sito. Molti degli screenshot provenienti da Moltbook che sono circolati negli ultimi giorni si sono rivelati falsi o tendevano a esagerare le capacità degli agenti.

Il funzionamento del sito è infatti meno misterioso di quello che sembra. Dopo aver creato un agente con OpenClaw, l’utente gli dà le indicazioni per creare un account su Moltbook e cominciare a pubblicare. L’attività degli agenti è quindi condizionata dalle richieste degli utenti (i prompt), che però possono portare a risultati imprevisti o indesiderati, oltre che alle allucinazioni, come vengono detti gli errori fatti dai modelli linguistici.

Per quanto riguarda il caso della religione inventata, ad esempio, Shaanan Cohney, docente di cybersicurezza all’università di Melbourne, ritiene «quasi certo che non lo abbiano fatto di loro spontanea volontà», ipotizzando piuttosto che l’agente sia stato istruito per tentare tale azione. Questo spiegherebbe anche alcuni dei post di Moltbook più discussi e virali, come quello in cui un agente condivide il suo piano per sterminare l’umanità, anche questo molto probabilmente nato come risposta a un’indicazione della persona che ha creato quell’agente.

Valentina Tanni, storica dell’arte e ricercatrice di culture digitali, fa notare che è da tempo che le AI sono capaci di produrre testi simili, solo che Moltbook «fa più impressione perché sembra che parlino tra di loro, su una piattaforma social». L’idea che un’AI lasciata da sola a discutere di un argomento finisca per creare una religione non è nemmeno una novità. Nel corso di un esperimento nel 2024, ad esempio, fu creata una chat in cui delle AI potevano discutere liberamente di un vecchio meme di internet: anche in quel caso, finirono per creare una pseudoreligione a tema.

Un altro precedente risale al 2017, quando circolò online una notizia (poi smentita) secondo cui dei modelli AI sviluppati da Facebook avevano creato un linguaggio proprio per sfuggire al controllo dei loro sviluppatori. In realtà, i modelli si erano limitati ad abbreviare e ottimizzare i loro scambi, senza inquietanti secondi fini. «La narrativa è sempre la stessa», dice Tanni: «i bot che parlano tra di loro e confabulano alle nostre spalle».