I video falsi influenzano anche chi sa che sono falsi

Vale per i contenuti fatti con l'intelligenza artificiale ma anche per altre forme di disinformazione: avvisare non basta

Due psicologi dell’università di Bristol, nel Regno Unito, hanno recentemente pubblicato un articolo su un loro esperimento fatto nel 2024, in cui ipotizzavano che anche un video fatto con l’intelligenza artificiale, palesemente falso e segnalato come tale, possa influenzare ciò che le persone pensano.

Durante l’esperimento due ricercatori, Stephan Lewandowsky e Simon Clark, mostrarono un video a un gruppo di persone, dicendo loro che la donna nel video era un’influencer vegana di 27 anni, Amelia Palmer, e che quel video era circolato moltissimo sui social media. Nel video, lungo un paio di minuti, lei sembrava confermare certe indiscrezioni sul fatto che qualcuno l’avesse vista mangiare un hamburger di carne in un ristorante. Poi si scusava, dicendo di aver passato un momento di difficoltà.

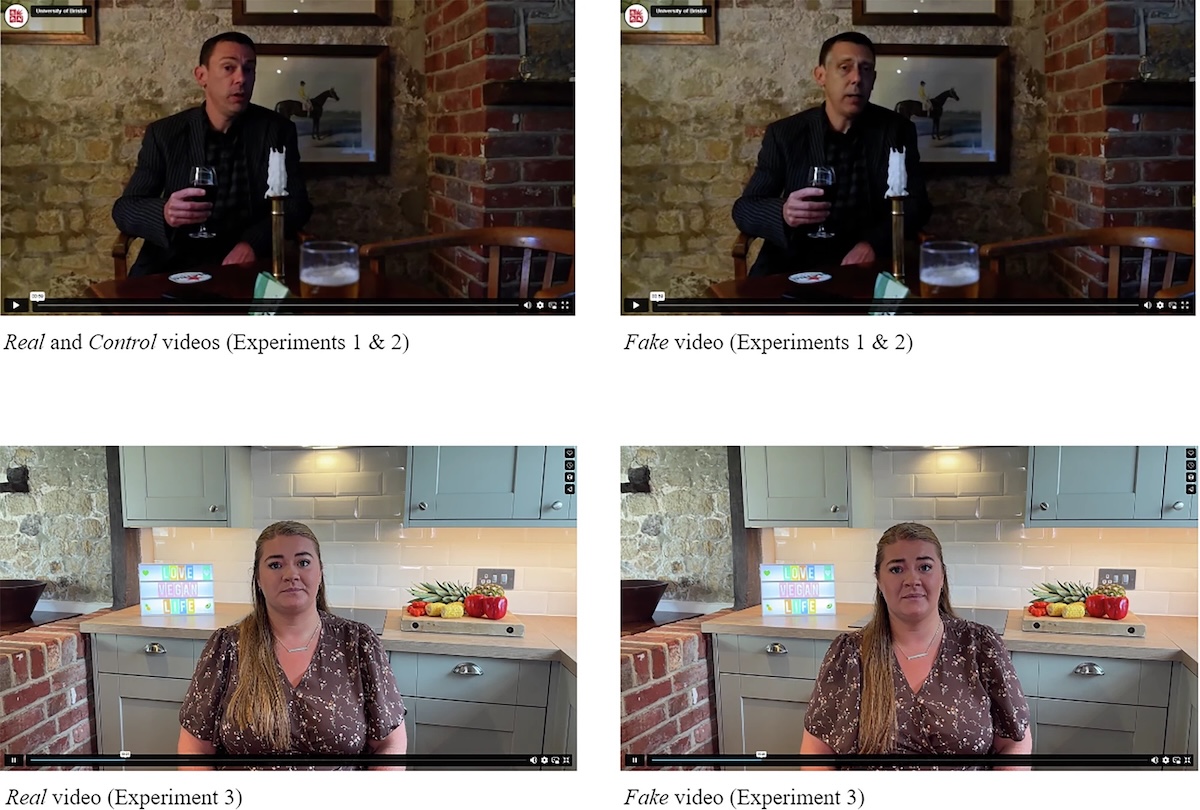

I ricercatori, però, usarono due video diversi per due gruppi di persone diverse. A un gruppo di partecipanti ne mostrarono uno con una persona vera; all’altro gruppo ne mostrarono una versione deepfake, creata con un software di intelligenza artificiale. Il copione era uguale. Ad alcuni partecipanti del secondo gruppo, poi, subito prima dell’inizio del video, fu detto esplicitamente che il video era stato etichettato come falso.

Alla fine dell’esperimento i ricercatori chiesero a ciascun partecipante di rispondere alla domanda: «pensi che l’influencer vegana Amelia Palmer sia stata vista mangiare un hamburger?». Quasi tutti risposero sì, inclusa una gran parte dei partecipanti che sapevano di aver visto un video falso, e dai quali ci si aspettava che scegliessero invece la risposta: «è impossibile dirlo».

I risultati dell’esperimento e di altri due simili sono stati pubblicati in un recente articolo su Communications Psychology, una delle riviste del gruppo Nature. Da quando lo studio era stato avviato, circa due anni fa, i video fatti con l’intelligenza artificiale sono diventati molto più accurati e gli strumenti delle piattaforme social per riconoscerli ed etichettarli meno efficaci.

Alcuni fotogrammi dei video mostrati per gli esperimenti (The continued influence of AI-generated deepfake videos despite transparency warnings/Communications Psychology)

I ricercatori fecero un’altra domanda ai partecipanti, dopo la visione del video dell’influencer vegana: «pensi che questo video sia un deepfake?». Soltanto il 60 per cento del gruppo che aveva visto il video deepfake e sapeva fosse falso rispose sì alla domanda.

Tra i partecipanti convinti della falsità del video soltanto il 20 per cento fece riferimento all’avvertimento letto all’inizio, mentre tutti gli altri motivarono la loro convinzione indicando imperfezioni grafiche e altri aspetti tecnici di cui si erano accorti. In questo gruppo dichiaratamente convinto che il video fosse falso, tra l’altro, la metà pensava comunque che qualcuno avesse visto l’influencer mangiare l’hamburger.

Le possibili ripercussioni della tecnologia dei video deepfake sul dibattito pubblico sono da tempo oggetto di riflessioni. La maggior parte della discussione in ambito accademico si è concentrata sul rischio che i deepfake siano utilizzati per screditare, minacciare o fare del male alle persone, o per influenzare le loro idee politiche facendo credere che contenuti falsi siano veri. Studi come quello di Lewandowsky e Clark si concentrano invece su un altro rischio: che anche video segnalati come falsi possono influenzare ciò che le persone pensano.

È un’idea da tempo al centro di un corposo filone di ricerche di psicologia e di scienze cognitive e sociali, anche se finora non era stata associata ai deepfake. Diversi studi sulla disinformazione in generale mostrano che, una volta apprese, le informazioni false continuano a condizionare ragionamenti e giudizi anche se vengono ritrattate: un effetto noto come “influenza continua”. Se viene smentita la notizia che una famiglia è morta dopo aver mangiato dei funghi velenosi in un ristorante, per esempio, i clienti tenderanno a evitare quel ristorante anche dopo aver saputo che quella famiglia era morta per altre ragioni.

– Leggi anche: La disinformazione è un problema diverso da come lo immaginiamo

È anche nota e ampiamente documentata una certa predisposizione delle persone a credere più facilmente a ciò che non contraddice un’idea che si sono fatte, e a ciò che percepiscono come familiare perché lo hanno già letto o sentito da qualche parte. Alcuni studi lo definiscono “effetto illusorio della verità”: quando certe affermazioni dubbie vengono ripetute più volte nel tempo il loro valore generale di veridicità tende ad aumentare. Allo stesso modo, l’amplificazione prolungata e duratura di una fake news può accrescere la disponibilità a crederla vera, anche se ha un titolo molto enfatico.

Le rettifiche alle informazioni false servono, ma fino a un certo punto. Apprendere informazioni negative sul conto di un politico, per esempio, può modificare i sentimenti a lungo termine verso quel politico, anche dopo che quelle informazioni vengono screditate. È una delle ragioni per cui le iniziative di debunking sui social media hanno un’efficacia dimostrata ma comunque limitata: non annullano ogni effetto di ciò che smentiscono.

Gli esperimenti nello studio di Lewandowsky e Clark sono un caso diverso, perché l’avviso precedeva la visione del contenuto falso: è più un esempio di prebunking. Ma anche per gli approcci preventivi alla disinformazione, come per quelli successivi, la loro efficacia dipende da diversi fattori: non sempre avvisare le persone in anticipo le protegge dal rischio di essere disinformate, o le persuade del tutto a pensarla diversamente su determinati argomenti su cui hanno già un’idea.