Anche su Reddit c’è un problema di foto condivise senza consenso

È un caso ancora diverso da Facebook e da Telegram, e sono state introdotte delle misure per evitarlo, ma non è facile

Dopo la chiusura del gruppo Facebook “Mia Moglie” e del sito Phica.net, su cui migliaia di uomini condividevano e commentavano foto intime di partner, amiche e sconosciute senza il loro consenso, molti hanno cominciato a domandarsi se ci siano altri spazi digitali di questo tipo, aperti al pubblico ma sconosciuti ai più. La app più citata, in questo senso, è Telegram, dove esistono notoriamente migliaia di chat di varia grandezza in cui circolano foto di questo tipo impossibili da far chiudere.

C’è un’altra piattaforma, però, di cui si parla molto meno ma che da anni ospita gruppi simili. È Reddit, uno degli ultimi social network mainstream a permettere la condivisione di contenuti sessualmente espliciti, nei limiti della legge. Su Reddit, notoriamente, circola moltissimo porno e non è facile per la piattaforma distinguere tra contenuti pubblicati illegalmente e non.

A chi cerca contenuti porno basta entrare in una delle migliaia di comunità di Reddit (dette “subreddit”) contrassegnate con l’etichetta “NSFW”, “Not Safe For Work”, cioè che non è il caso di aprire mentre si è al lavoro. Non si trovano nella homepage del sito e sono un po’ più difficili da trovare tramite la barra di ricerca interna di Reddit, ma sono aperti e alla portata di chiunque sia intenzionato a trovarli.

Spesso in questi gruppi foto e video sono condivisi dalle stesse persone ritratte. Tantissime sex worker, per esempio, usano Reddit per raggiungere nuovi utenti che potrebbero essere interessati a iscriversi al loro canale su OnlyFans, e altri utenti condividono proprie foto di nudo semplicemente per ricevere apprezzamenti e pareri. Tra tutti questi contenuti consensuali, però, se ne trovano anche di illegali.

In italiano ne esistono molti meno che in inglese, anche se qualcuno c’è: uno dei più storici, r/PatatinaVipForum, oggi è privato, ma ancora attivo. Un altro, r/troiesborrate, non è molto conosciuto – viene visitato da circa 6mila utenti unici al mese – ma contiene tutti gli stessi comportamenti che si potevano trovare su Phica: c’è chi «scambia tipe in privato», chi «manda [foto di] amiche troie» e chi condivide foto di donne che conosce in costume o pose seducenti chiamandole «troione» e «zoccolone». Almeno un post è dedicato alla sorella di un utente: i commenti sono spesso molto volgari. Al momento il subreddit è ancora attivo e pubblico.

A differenza di Telegram, Reddit si sforza di individuare questi gruppi e chiuderli. Soltanto nei primi sei mesi del 2024, per esempio, ha rimosso quasi 306mila contenuti che violavano le sue regole sulla sessualizzazione dei minorenni. Nello stesso periodo ha bandito 3.649 subreddit dentro a cui gli utenti si scambiavano foto e video porno senza il consenso delle persone ritratte: in Italia farlo è un reato, conosciuto da molti come “revenge porn”.

– Leggi anche: Storie comuni di foto condivise senza consenso

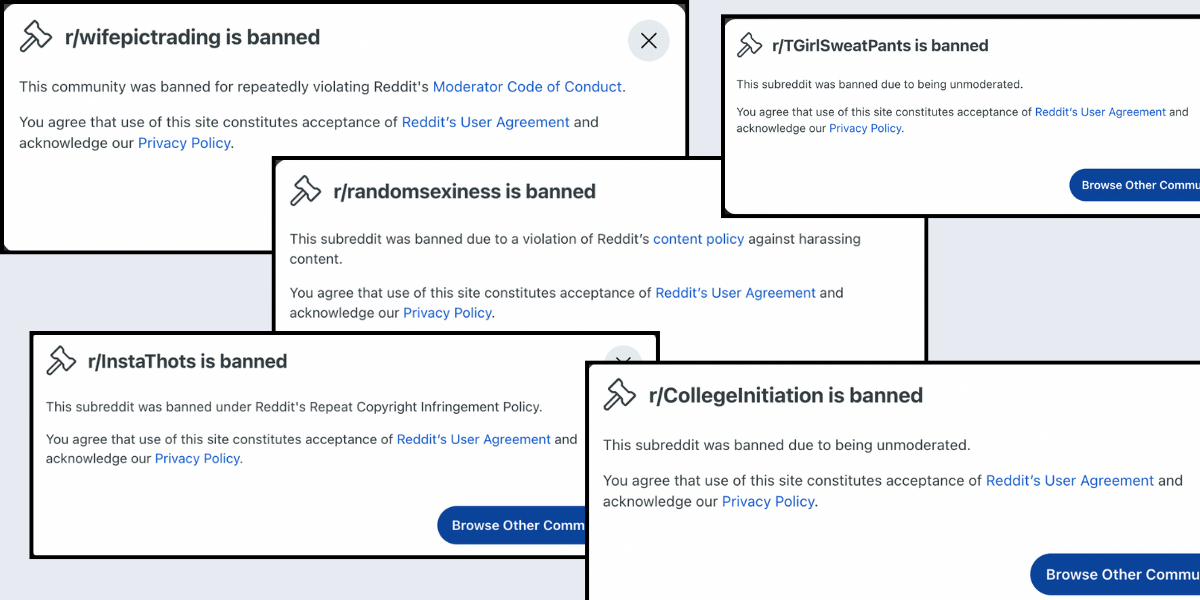

Da anni online circolano delle lunghe liste, dette “masterpost”, che includono i link a migliaia di subreddit NSFW. Scorrendole, si trovano comunità con titoli che fanno riferimento in modo molto esplicito alla condivisione non consensuale di materiale intimo, come r/wifetradingpics (“scambio di foto di mogli”) e r/socialmediasluts (“puttane prese dai social media”).

Oggi, quasi nessuno di questi subreddit esiste più, e quasi sempre la spiegazione è che queste comunità «non erano moderate», ovvero che i moderatori del gruppo, che dovrebbero essere i primi ad assicurarsi che le regole della piattaforma siano rispettate, non lo facevano. In altri casi, la spiegazione è ancora più esplicita: r/InstaSnapsAndMore, per esempio, dove gli utenti pubblicavano e commentavano foto di donne prese da Instagram e Snapchat, è stato bandito «per aver violato le regole di Reddit sulla condivisione non consensuale di materiale intimo».

Reddit ha cominciato a introdurre le prime regole sul tema nel 2015, come reazione un po’ tardiva al caso di r/TheFappening, seguitissimo subreddit su cui per mesi, tra l’agosto del 2014 e il settembre del 2015, vennero pubblicate decine di foto di celebrità nude ottenute in modo illegale. All’epoca, Reddit bandì r/TheFappening per «violazione del copyright».

La formulazione odierna, invece, è del 2023: oggi, il sito vieta «la condivisione di immagini intime o sessualmente esplicite create o condivise senza il permesso della persona ritratta». Questo divieto include anche eventuali immagini generate con l’intelligenza artificiale o scattate in pubblico: per molto tempo, infatti, su Reddit sono andate forte le comunità dove si condividevano “creepshots”, ovvero foto di sconosciute incontrate in pubblico a cui magari si intravedevano i capezzoli attraverso la maglietta, o a cui venivano fotografate le mutande puntando una telecamera sotto alle loro gonne senza che se ne accorgessero. Tra gli esempi concreti di immagini vietate elencati da Reddit ci sono «immagini di qualcuno che prende il sole in topless nel proprio giardino, scattate senza la sua autorizzazione» ma anche «screenshot di modelle famose condivisi pubblicamente senza il loro consenso».

– Leggi anche: Quello che succedeva su Phica.net era legale?

Nonostante la maggiore attenzione dell’azienda, però, capita ancora che gruppi e individui problematici riescano a usare Reddit per periodi prolungati prima che qualcuno se ne accorga. Nel 2021, per esempio, si è scoperto che il sindaco 32enne di una cittadina statunitense aveva creato vari profili in cui fingeva di essere la sua ex fidanzata e aveva pubblicato foto di lei nuda su vari subreddit NSFW anche molto spinti, creandone di nuovi man mano che quelli precedenti venivano bloccati. Nel 2022, poi, la BBC raccontò dell’esistenza di un subreddit molto simile a Phica, in cui i membri prendevano le foto dai profili Instagram delle donne che conoscevano e le pubblicavano insieme ai loro dati personali – nome e cognome, contatti sui social network, informazioni sulle zone in cui vivevano – sapendo che gli altri avrebbero scritto loro commenti offensivi e violenti.

Tuttora è online r/MoreSexyASMRGirls, subreddit da 197mila visitatori unici alla settimana in cui gli utenti condividono foto e video di content creator senza il loro consenso. In molti casi, si tratta di creator che pubblicano anche contenuti a sfondo sessuale su canali privati come OnlyFans: prendere le loro foto e condividerle altrove rientra, almeno secondo la legge italiana, nel reato di condivisione non consensuale di materiale intimo. In altri casi, gli utenti prendono foto e video di creator che non hanno mai pubblicato contenuti per adulti e le sessualizzano, lamentandosi del fatto che «dovrebbero mostrare di più». Molto spesso, sotto ai post si trovano commenti degradanti simili a quelli pubblicati su siti come Phica.net.

Per Reddit la difficoltà principale rispetto a social network come Facebook, dove sono vietati tutti i contenuti sessualmente espliciti, a prescindere dal consenso della persona ritratta, è che distinguere tra le foto pubblicate legalmente e quelle illegali richiede di prestare molta attenzione al contesto.

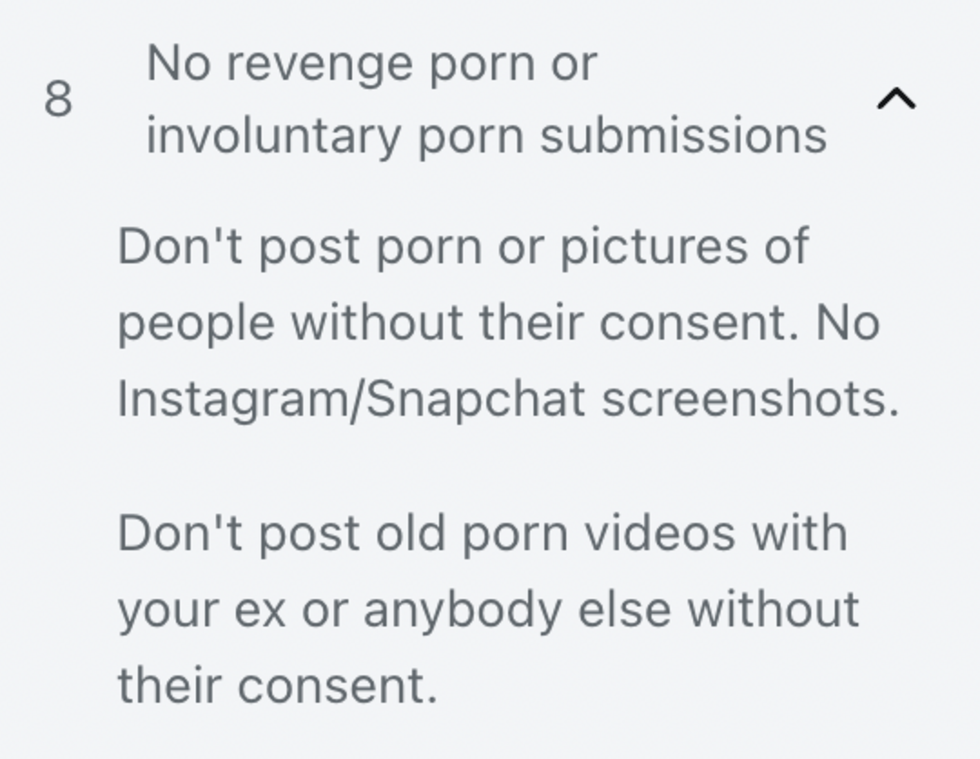

Il subreddit r/gonewild, per esempio, ha 5 milioni di follower: in base alla descrizione, è uno spazio dove «adulti di mentalità aperta possono condividere i loro corpi nudi, mostrandoli in un ambiente accogliente e senza pressioni». La prima volta che una persona prova a pubblicare un post, i moderatori gli chiedono di verificare la sua identità, in modo da assicurarsi per quanto possibile che a pubblicare i contenuti sia effettivamente la persona ritratta. Altri subreddit molto popolari scrivono esplicitamente, tra le regole della comunità, «No revenge porn», «No foto prese da Instagram o Snapchat», ma anche «Non provate a indovinare l’identità di qualcuno o a cercarla su altri social network».

Una regola che sottolinea il divieto di condividere materiale intimo senza consenso in un subreddit NSFW (Il Post)

Intervistato nel 2023, il fondatore di Reddit Steve Huffman disse che l’azienda stava cercando di fare del proprio meglio per continuare a permettere la condivisione di materiale sessualmente esplicito e, al contempo, evitare la proliferazione di casi di revenge porn e pedopornografia.

Da allora, i report semestrali condivisi da Reddit mostrano effettivamente che il numero dei post e dei subreddit eliminati e degli utenti bannati per queste cose è sempre in aumento, soprattutto grazie al lavoro dei moderatori. È comunque probabile che molti casi non siano ancora stati scoperti e segnalati perché, molto spesso, le vittime non hanno idea che le loro foto sono state condivise e quindi non ne chiedono la rimozione.

– Leggi anche: Reddit è rimasto uguale mentre intorno Internet peggiorava