Leggere la mente con un computer

Gli ultimi progressi stanno avvicinando gli impianti cerebrali all'obiettivo di avere conversazioni in tempo reale con chi non riesce più a parlare

Venti anni fa Ann perse la capacità di parlare a causa di un ictus. Oggi, grazie a un impianto cerebrale, riesce di nuovo a comunicare: pensa le parole che vorrebbe dire e un computer le pronuncia per lei, imitandone la voce. Il sistema è ancora sperimentale, ma negli ultimi anni il gruppo di ricerca che lo ha sviluppato ha raggiunto importanti progressi, soprattutto nei tempi di reazione per avvicinarli a quelli di una normale conversazione. Siamo ancora lontani da applicazioni commerciali, ma il caso di Ann mostra le potenzialità delle interfacce cervello-computer che un giorno potrebbero migliorare la vita di milioni di persone.

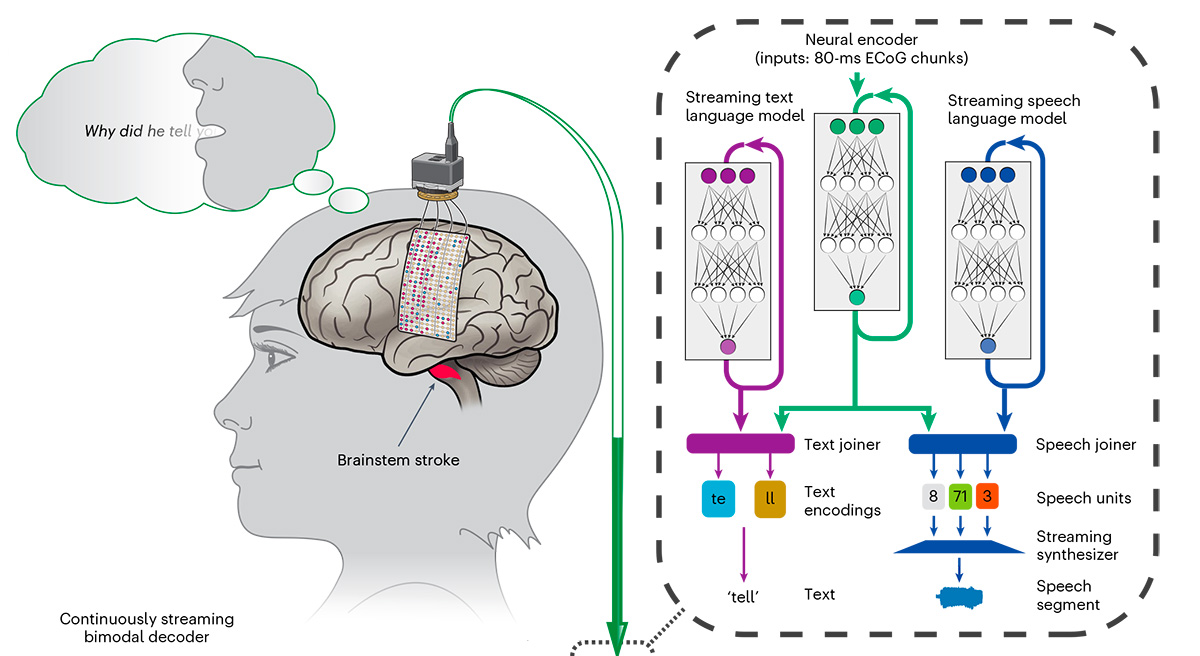

Nell’emisfero sinistro del cervello di Ann c’è una striscia lunga qualche centimetro e sottile come un foglio di carta. Le è stata impiantata nel 2022 con un intervento chirurgico sovrapponendola alla corteccia sensomotoria del linguaggio, la parte del lobo frontale coinvolta nella produzione delle parole.

L’impianto è una griglia costellata di 253 piccoli elettrodi a contatto con il tessuto cerebrale, che rilevano l’attività elettrica derivante dai neuroni e la trasmettono tramite alcuni cavi molto sottili a un dispositivo collocato all’esterno del cranio. Da qui, un paio di cavi simili a quelli che si usano per caricare uno smartphone raggiungono un computer, che si occupa di elaborare i dati.

L’impianto di Ann non è il primo nel suo genere: negli ultimi anni il settore delle interfacce cervello-computer è diventato affollato e ha suscitato più interesse rispetto a un tempo soprattutto per via di Neuralink, la società di Elon Musk che promette di produrre impianti per controllare con la mente i computer. Le aziende private hanno un ruolo importante nello sviluppo di queste tecnologie e soprattutto ne intravedono le grandi opportunità economiche, ma una parte importante della ricerca è svolta dalle università con gruppi interdisciplinari.

Edward Chang è un neurochirurgo del campus di San Francisco dell’Università della California e coordina un gruppo di lavoro su queste tecnologie, insieme ad alcuni colleghi del campus di Berkeley. In uno studio da poco pubblicato sulla rivista scientifica Nature Neuroscience, il gruppo di ricerca ha esposto gli ultimi progressi raggiunti con l’impianto di Ann, soprattutto nei tempi di analisi e di risposta degli impulsi provenienti dal suo cervello.

Nei test svolti negli anni passati, c’era un ritardo di circa otto secondi tra il momento in cui Ann pensava di pronunciare una frase e la riproduzione delle sue parole da parte del computer. Grazie ad alcune importanti migliorie, rese possibili soprattutto da sistemi di intelligenza artificiale e da una gestione in tempo reale degli impulsi, ora il computer riproduce le parole pensate da Ann con poco ritardo (circa un secondo), rendendo possibile una conversazione quasi normale, per quanto possa esserne una mediata da un computer collegato al cervello di una persona. Ann non può parlare, ma sente normalmente, quindi più i tempi di risposta del computer sono brevi, più può avere un’esperienza che si avvicina molto a quella di una chiacchierata.

Nel video, Ann testa una precedente versione dell’interfaccia cervello-computer

In una prima fase il sistema di intelligenza artificiale (una rete neurale di tipo RNN-T) è stato allenato facendo leggere ad Ann alcune semplici frasi su uno schermo, chiedendole di immaginare di pronunciarle. In questo modo il gruppo di ricerca ha potuto sovrapporre la sua attività cerebrale alle frasi, trovando corrispondenze e andamenti da usare per la produzione di altre parole. È stato poi utilizzato un sistema per la generazione di testi e per la sintesi vocale, sempre basato sull’intelligenza artificiale, che aveva come base alcune registrazioni della voce di Ann ottenute da vecchi video del suo matrimonio. In questo modo il gruppo di ricerca ha potuto riprodurre una versione sintetica della sua voce, per rendere più realistica l’esperienza.

Per ridurre la latenza, cioè il tempo che intercorre tra il momento in cui il cervello di Ann decide di provare a parlare e il momento in cui il suono esce effettivamente dal computer, il gruppo di ricerca ha sviluppato un sistema per identificare specifici segnali elettrici tra i neuroni che indicano l’imminente tentativo di parlare. Il processo impiega un secondo circa per generare il suono delle parole pensate. Dopodiché il gruppo di ricerca ha ulteriormente affinato il sistema per fare in modo di rilevare l’intento di parlare anche mentre sta riproducendo una frase, così da ridurre i tempi tra una parola e l’altra e fornire un risultato quasi in tempo reale.

Il test è stato svolto sia utilizzando parole già note al sistema, perché usate durante la fase di allenamento, sia utilizzandone di nuove che il computer non aveva mai gestito prima. Anche in questo secondo caso è stato possibile riprodurle con un buon livello di accuratezza, a dimostrazione del fatto che il sistema continua ad apprendere e ad affinare il proprio funzionamento con l’utilizzo.

I progressi nella resa delle parole e soprattutto nella riduzione dei tempi di risposta sono essenziali per offrire ai pazienti impianti che possano effettivamente migliorare la loro vita. La generazione precedente di interfacce cervello-computer funzionavano un po’ come una chat di WhatsApp, ha spiegato un ricercatore non coinvolto nello studio a Nature: «Scrivo una frase, tu scrivi una frase e devi attendere un po’ di tempo per scriverne un’altra. Non hai un flusso come in una normale conversazione». L’idea è di superare questo modello con interfacce di nuova generazione che siano più simili a una videochiamata che a una chat.

La latenza è stata ridotta di molto rispetto al sistema precedente, ma c’è ancora e richiederà ulteriore lavoro. Il ritardo intorno al secondo è distante dalle pause cui siamo abituati nelle normali conversazioni di qualche decina di millisecondi. Diversi studi hanno segnalato come anche solo un ritardo superiore a 50 millisecondi renda meno naturale l’interazione tra le persone, con un peggioramento della qualità dello scambio e il rischio di confusioni.

Chang è comunque ottimista: «Ora siamo a questo punto. Ma pensa, con più sensori, con più precisione e con un’elaborazione del segnale potenziata queste cose cambieranno e miglioreranno». Le difficoltà da superare sono comunque ancora molte e riguardano anche la durata degli impianti.

Umidità e temperatura all’interno della scatola cranica possono causare il deterioramento in pochi anni e non sempre la loro sostituzione è semplice. Il tipo impiegato dal gruppo di ricerca rimane appoggiato sul tessuto cerebrale ed è quindi mediamente invasivo, ma ce ne sono di più invasivi con elettrodi che penetrano nel cervello come quelli impiegati da Neuralink. La società ha ottenuto importanti risultati negli ultimi anni, ma ha dovuto confrontarsi proprio con le difficoltà di tenuta dei propri elettrodi nel tessuto cerebrale.

Sistemi come quello sperimentato in California potrebbero rivelarsi molto utili per le persone con “sindrome locked-in”, cioè con pazienti che sono svegli e coscienti, ma che non hanno controllo di buona parte dei loro movimenti a causa della paralisi dei muscoli volontari del corpo. La sindrome può essere causata da un grave trauma, per esempio al sistema nervoso centrale, oppure da un ictus come nel caso di Ann. Alcune malattie, come la sclerosi laterale amiotrofica (SLA), rendono impossibili i movimenti volontari e dunque la possibilità di comunicare facilmente con le altre persone: anche in questo caso un impianto potrebbe ridurre il forte senso di isolamento che spesso provano le persone con questa malattia.

I progressi ottenuti negli ultimi anni da parte di centri di ricerca e aziende sono ritenuti molto promettenti, ma rimangono comunque nell’ambito di esperienze di ricerca su una quantità limitata di persone. Saranno necessari ancora anni prima di avere sistemi pratici da usare, e soprattutto portatili, ma gli investimenti nel settore non mancano.

Per quanto sia ancora sperimentale e abbia un po’ di latenza, il sistema sperimentato con Ann è incomparabile con quello che ha utilizzato per anni, e che usano molte persone nelle sue condizioni. Consiste nel controllare un puntatore su uno schermo con un paio di occhiali, il cui movimento viene rilevato dal sensore di un computer, in modo da selezionare da una tabella le lettere per formare parole e frasi. La produzione di una singola frase può richiedere più di 20 secondi.