Un’intelligenza artificiale le farà sapere

I software che automatizzano la selezione del personale sono sempre più diffusi, ma c'è un esteso dibattito sui limiti e il rischio di discriminazioni

La selezione e l’assunzione del personale da parte delle grandi aziende è uno dei numerosi ambiti in cui l’intelligenza artificiale ha trovato spazi e modalità di applicazione crescenti. Le misure introdotte da molti paesi per limitare l’epidemia di COVID-19, che hanno accresciuto il volume di lavoro svolto da remoto, hanno accelerato questa tendenza, fornendo alle imprese strumenti utili a selezionare e valutare con maggiori rapidità ed efficienza una quantità di candidati in molti casi superiore alle medie precedenti. Parallelamente alla presenza dell’intelligenza artificiale nella selezione del personale si è sviluppato di pari passo un esteso dibattito sugli effetti, sui benefici e sui rischi di queste procedure sempre più diffuse, che si inscrive a sua volta in un più ampio dibattito sui limiti della tecnologia, intesi sia come perfettibilità attuale di quegli strumenti sia come confini etici da individuare ed eventualmente tracciare nella pratica di tutti i giorni.

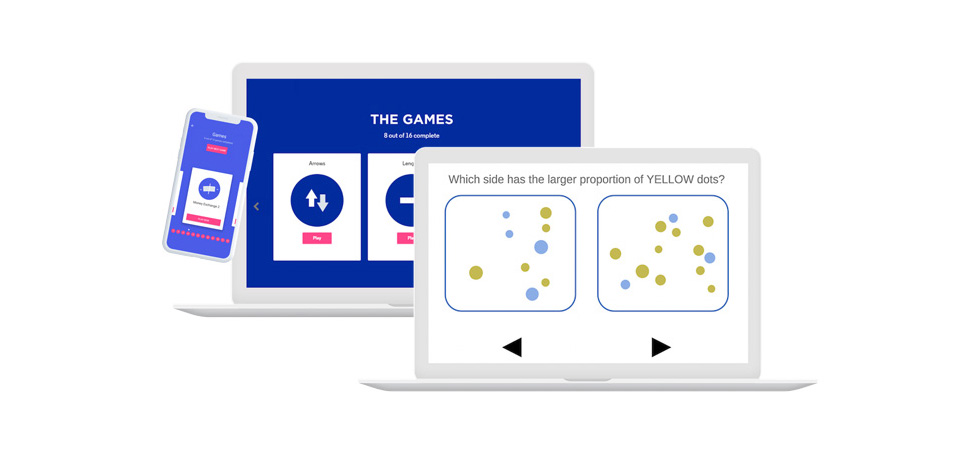

In un articolo per BBC la giornalista Andrea Murad ha raccontato una sua esperienza diretta e recente nella presentazione di una domanda di lavoro. «Francamente è stato un po’ stressante sapere che la mia domanda era valutata da un computer e non da un essere umano», ha chiarito subito. Come prima parte della procedura di selezione online Murad doveva completare una serie di «giochi principali»: contare tutti i punti presenti in due caselle, per esempio, o abbinare le espressioni di una serie di volti umani alle relative emozioni. Era un test di 25 minuti con 12 giochi sviluppati per misurare abilità emotive e cognitive. Il programma ha quindi valutato la personalità della candidata e, sottolinea Murad, senza alcun intervento umano diretto in quella prima fase. Da allora Murad non è ancora stata ricontattata dall’azienda per proseguire il colloquio.

Pymetrics e HireVue

Il software usato per la valutazione della domanda di lavoro presentata da Murad si chiama Pymetrics ed è sviluppato da un’azienda di New York. Come la mettono loro stessi sulla pagina di presentazione del software, disponibile in 20 lingue, è uno strumento fatto per «raccogliere dati imparziali» e per «misurare il potenziale, non il pedigree». Nelle fasi che precedono il colloquio con un responsabile delle risorse umane lo utilizzano, tra gli altri, grandi aziende multinazionali come la banca JP Morgan, McDonald, la società di consulenza PricewaterhouseCoopers e il gruppo del settore alimentare Kraft Heinz. L’obiettivo di Pymetrics è di favorire valutazioni iniziali basate non sui curriculum dei candidati ma su «dati comportamentali oggettivi», a fronte di una precedente calibrazione personalizzata dell’algoritmo da parte del datore di lavoro, basata sulle esigenze e priorità dell’azienda.

Secondo la fondatrice Frida Polli, Pymetrics è sviluppato in modo da aiutare le aziende ad ampliare il bacino di candidati e raccogliere «segnali» utili a capire se una certa persona potrebbe avere successo in quel lavoro. L’utilizzo di sistemi di intelligenza artificiale in questo campo dovrebbe, dal suo punto di vista, favorire l’interazione tra aziende e candidati, facendo il bene di entrambe le parti. «Tutti vogliono il lavoro giusto e tutte le aziende vogliono assumere le persone giuste: non conviene a nessuno se la partita si interrompe», ha detto Polli.

La decisione se proseguire o interrompere il processo di selezione al termine di una prima fase di valutazione interamente gestita da un software spetta chiaramente all’azienda. Vale anche per un altro software molto utilizzato per la selezione del personale, HireVue, sviluppato da un’azienda di South Jordan, vicino Salt Lake City, nello Utah. È utilizzato, tra gli altri, dalla multinazionale olandese-britannica Unilever.

La funzione principale di HireVue, disponibile dal 2016, permette di raccogliere le videoregistrazioni dei colloqui iniziali con i candidati, ai quali viene richiesto su appuntamento di rispondere tramite laptop, tablet o smartphone a una serie di domande standard. L’audio del colloquio viene quindi trascritto e analizzato in automatico dal sistema in base ad alcuni criteri precedentemente approvati dal datore di lavoro: va alla ricerca di parole chiave come “io” anziché “noi” nelle risposte a domande sul lavoro di squadra, per esempio. La valutazione è basata anche su altri criteri, come la frequenza del contatto visivo con la videocamera e le espressioni facciali nel corso del colloquio.

HireVue stima che su un totale di 19 milioni di videocolloqui raccolti tra i candidati, circa il 20 per cento sia svolto senza bisogno di un operatore umano dall’altra parte. «Ci permette di abbreviare l’intero processo di assunzione», raccontava nel 2017 il responsabile delle selezioni per l’azienda di bevande analcoliche Dr Pepper, spiegando che una loro procedura che poteva arrivare a richiedere tre settimane si concludeva mediamente in due giorni, spesso anche meno, grazie a HireVue.

Riguardo ai rischi generalmente discussi a proposito dell’integrazione dell’intelligenza artificiale nella selezione del personale, l’amministratore delegato di HireVue Kevin Parker sostiene che l’analisi di un colloquio tramite software sia più «imparziale» di quella di un operatore umano. La pensa allo stesso modo anche Polli, fondatrice di Pymetrics, quando sostiene che «ogni algoritmo è rigorosamente testato per rintracciare eventuali pregiudizi» e che affidarsi a questo tipo di analisi tramite software è meglio che basarle soltanto sulla valutazione delle precedenti esperienze del candidato. I curriculum sono utili a fornire informazioni sulle «hard skills» (le competenze tecniche di base), secondo Polli, ma non dicono niente sulle «soft skills (le competenze relazionali), fondamentali per il successo sul lavoro».

Altri software basati su sistema di intelligenza artificiale sono impiegati dalle aziende anche per la ricerca attiva del personale. La piattaforma sviluppata dall’azienda di Seattle Textio, peraltro utilizzata da note aziende come Spotify, Tesco e Dropbox, permette di compilare annunci di lavoro utilizzando un linguaggio inclusivo e facile da comprendere per un bacino quanto più ampio possibile di candidati. Un altro software, sviluppato dalla società californiana Korn Ferry, permette alle aziende di analizzare approfonditamente vari tipi di contenuti presenti su Internet per selezionare profili professionali potenzialmente utili e contattarli prima ancora che siano loro a contattare l’azienda.

– Leggi anche: Questa intelligenza artificiale risolve un grande problema

I criteri discriminatori

Nel 2018 un’inchiesta di Reuters poi molto ripresa contribuì a rendere noti alcuni difetti di un sistema sperimentale di intelligenza artificiale precedentemente sviluppato da Amazon per i processi di selezione del personale e basato su tecniche di apprendimento automatico (machine learning). Assegnava ai candidati un punteggio da uno a cinque e sembrò inizialmente uno strumento molto potente e comodo. Si scoprì però che i candidati non erano valutati in modo imparziale rispetto al loro genere sessuale. In sostanza il sistema era stato “addestrato” implementando i curriculum ricevuti da Amazon nei precedenti dieci anni, la maggior parte dei quali provenienti da candidati maschi come riflesso del predominio maschile nell’assunzione del personale tecnico da parte dell’azienda.

Per la selezione degli sviluppatori di software, per esempio, il sistema di intelligenza artificiale aveva quindi seguito schemi individuati nelle informazioni inserite dai programmatori. E l’apprendimento automatico aveva portato a penalizzare i curriculum che includessero l’espressione “femminile” (come in “capitana del club di scacchi femminile”, per esempio). Fonti interne all’azienda consultate allora da Reuters citarono il caso di declassamento di due gruppi di candidate qualificate dovuto soltanto al fatto che avessero frequentato college “femminili”.

Gli interventi umani successivi alla scoperta dell’errore – necessari in ogni caso in questi processi di apprendimento automatico – non potevano garantire che il sistema non avrebbe individuato e applicato altri criteri discriminatori di classificazione sulla base dei dati acquisiti, e Amazon abbandonò quel progetto alla fine del 2017. L’azienda specificò comunque di non aver mai basato le selezioni del personale sulle classifiche ottenute tramite quello strumento.

Il pregiudizio di genere non fu l’unico problema emerso durante le verifiche del team di sviluppo del sistema. Tra i circa 50 mila termini individuati nei database di curriculum di “addestramento”, l’apprendimento automatico aveva portato ad assegnare minore rilevanza ai termini che denotavano competenze abbastanza comuni per ciascuna specifica ricerca di personale (la conoscenza di determinati linguaggi di programmazione, per esempio). Aveva invece privilegiato i curriculum di candidati che nella propria descrizione usavano verbi più frequentemente ricorrenti nei curriculum degli ingegneri maschi. Con il risultato di una sproporzione tra l’importanza delle competenze tecniche, per quanto di base, rispetto alla scelta di alcuni termini rispetto ad altri nel curriculum.

I limiti dell’intelligenza artificiale

Secondo James Meachin, psicologo del lavoro per la società di consulenza britannica Pearn Kandola, i limiti attuali dei sistemi di intelligenza artificiale applicata ai processi di selezione del personale sono essenzialmente di due tipi. C’è prima di tutto da considerare un limite di base, comune in generale ai software di registrazione e analisi di contenuti audiovisivi, ha spiegato Meachin a BBC. Anche assistenti vocali perfezionati e noti come quelli di Google, Amazon e Apple hanno ancora difficoltà, per esempio, a comprendere tutte le parole pronunciate da persone con un marcato accento regionale (un esempio noto nel Regno Unito è quello scozzese). In caso di trascrizione corretta del testo la seconda difficoltà è di tipo semantico e riguarda il significato da assegnare alle parole in assenza di un contesto, laddove una valutazione umana riuscirebbe invece a cogliere abbastanza facilmente tutte le sfumature.

Sandra Wachter, professoressa associata di diritto presso l’Università di Oxford, ha invece parlato con l’autrice dell’articolo su BBC del problema forse più noto e discusso nel dibattito sull’intelligenza artificiale. Secondo Wachter, specializzata in protezione dei dati e leggi contro la discriminazione, allo stato attuale il rischio di basare l’assunzione del personale su algoritmi evoluti di selezione – senza adeguate fasi di sperimentazione e procedure di correzione degli errori – è quello di trascurare alcune categorie di persone che risultino eccezioni o minoranze nei dati di partenza.

Wachter ritiene che un sistema di selezione basato sull’apprendimento automatico ma non adeguatamente testato finirebbe per rafforzare anziché eliminare gli effetti di quei pregiudizi già presenti a monte dei dati usati per l’addestramento. «Chi erano i direttori in passato? Chi erano i docenti a Oxford in passato? Gli algoritmi selezioneranno allora più uomini», avverte Wachter, peraltro coautrice di un articolo scientifico che propone nozioni di “equità algoritmica” da qualche tempo impiegate anche da Amazon. I test proposti nell’articolo, utili a individuare pregiudizi cognitivi non intenzionali presenti nei set di dati, sono infatti parte di una suite disponibile per i clienti di Amazon Web Services, la divisione della società che si occupa di fornire sistemi di cloud.

A New York il consiglio comunale ha recentemente discusso una legge proposta dalla consigliera Democratica Laurie Cumbo che regolamenterebbe almeno in parte l’utilizzo dei sistemi di intelligenza artificiale nella selezione del personale. Se approvata, obbligherebbe le aziende a dichiarare apertamente l’eventuale utilizzo di software di questo tipo nella valutazione dei profili dei candidati. Le aziende dovrebbero inoltre sottoporsi a revisioni annuali degli strumenti tecnologici, per garantire che i processi di selezione non siano condizionati da pregiudizi, e rendere i risultati disponibili per i clienti.

– Leggi anche: L’etica dell’intelligenza artificiale

La proposta di legge – vista favorevolmente da diverse aziende, inclusa Pymetrics – non ha trovato sostegno unanime e ha anzi alimentato qualche perplessità riguardo alle questioni che lascerebbe irrisolte o aggraverebbe. Alcuni esperti di intelligenza artificiale – peraltro sostenuti da autorevoli gruppi come la National Association for the Advancement of Colored People (NAACP), una delle prime associazioni per i diritti civili negli Stati Uniti – ritengono impraticabile la misura suggerita da Cumbo. Ammesso che uno standard di revisione condiviso possa arrivare a garantire l’assenza di pregiudizi nei processi di selezione automatizzati, eventuali difetti o imperfezioni di quel modello di revisione non farebbero altro che rafforzare le strutture discriminanti esistenti conferendo loro una sorta di illegittimo certificato di qualità.

A essere contrari alla proposta di Cumbo sono poi i consiglieri che ritengono che i software che utilizzano l’intelligenza artificiale possano individuare e correggere eventuali pregiudizi presenti nelle procedure di selezione del personale, invece che accentuarli. Temono, perciò, che introdurre regolamentazioni troppo rigide potrebbe sfavorire il loro utilizzo, finendo così per rendere paradossalmente più inique le selezioni.