Siamo meglio di un’auto che si guida da sola?

Al suo posto faremmo scelte etiche migliori? Sul risparmiare la vita di un pedone o la nostra in un incidente, per esempio: non è semplice, come dimostra questo esperimento

Uno dei campi in cui gli studi sull’intelligenza artificiale (AI) si stanno concentrando di più è quello delle automobili che si guidano da sole. Su alcune automobili di Tesla Motors, una delle aziende fondate da Elon Musk, è già presente un autopilota che può essere attivato in alcune circostanze (in autostrada, per esempio) e Musk ha in programma di rendere più avanzata questa funzione, offrendola su tutti i nuovi modelli. Le case automobilistiche più tradizionali sono state più caute nello sviluppare questo tipo di sistemi, ma alcuni prototipi sono stati realizzati e ultimamente se ne parla sempre di più. Lo scorso gennaio Volvo ha presentato una versione della sua XC90 con guida autonoma. A febbraio Ford ha annunciato che nei prossimi cinque anni investirà un miliardo di dollari nella startup di sviluppo di intelligenze artificiale Argo AI, mentre il gruppo Volkswagen ha da poco annunciato un investimento da più di 165 milioni di euro nell’azienda cinese Mobvoi, che si occupa a sua volta di AI, anche se per ora è specializzata più che altro nel campo del riconoscimento vocale.

Fiat Chrysler Automobiles (FCA) ha prodotto alcuni esemplari di minivan Pacifica che si guidano da soli grazie alle tecnologie sviluppate in questi anni da Google, che da parte sua ha fondato una società apposta per sviluppare automobili “intelligenti”, Waymo. Apple sembra invece che abbia temporaneamente abbandonato i suoi più ambiziosi progetti in questo ambito, decidendo di concentrarsi sullo sviluppo di un sistema di guida automatica da fornire a case automobilistiche già esistenti. Anche Uber sta investendo molto nella tecnologia delle auto che si guidano da sole, dato che potrebbero contribuire a ridurre i costi del suo servizio, dovuti al personale.

I software utilizzati da Google, Uber e gli altri non sono ancora molto “intelligenti” e ripetono di continuo algoritmi per riconoscere la segnaletica stradale, la presenza degli altri veicoli, dei pedoni e fare previsioni su come si muoveranno intorno all’automobile. L’idea è però affinare questi sistemi in modo che tramite il machine learning imparino a migliorarsi, rendendo sempre più sicura e affidabile la guida automatica. Le automobili che si guidano da sole non sono comunque tutte uguali: ad esempio, il sistema di Tesla (e così quello della XC90 di Volvo) prevede che il passeggero al posto di guida rimanga costantemente concentrato sulla strada, e intervenga di continuo per modificare e correggere le decisioni automatiche dell’auto, mentre Google sta studiando il modo di rendere completamente autonoma l’auto, senza richiedere l’intervento del pilota. Le automobili di Google non sono ancora state commercializzate, ma quando lo saranno avranno un grado di autonomia maggiore rispetto alle Tesla.

Il funzionamento delle automobili che si guidano da sole è anche uno di quegli ambiti di sviluppo delle intelligenze artificiali che più vengono citati dagli studiosi che si occupano dei risvolti etici dell’uso delle AI. Queste macchine sono (meglio, saranno) in grado di riconoscere i segnali del codice della strada e di rispettare le regole di precedenza, ma non sappiamo ancora come si comporteranno quando dovranno evitare gli incidenti in cui sia i propri passeggeri che altre persone potrebbero rimanere coinvolti. La questione è molto complessa: potremmo essere tutti d’accordo che sia lecito investire un animale per salvare la vita di un passeggero, nel caso questa sia l’alternativa, ma come dovrebbe comportarsi un’auto che si guida da sola posta davanti alla scelta tra andare a sbattere contro un muro uccidendo i propri quattro passeggeri per non colpire una scolaresca?

Un gruppo di ricerca del Massachusetts Institute of Technology (MIT) ha realizzato un esperimento – accessibile a tutti sul sito Moral Machine – per mostrare i limiti connessi a queste scelte e come in alcuni casi anche un essere umano possa trovarsi in difficoltà nel compiere una scelta etica in potenziali circostanze di incidente stradale. L’effetto collaterale di questo esperimento, di cui vi proponiamo le parti più rilevanti, è di mettere in discussione le proprie capacità di stabilire quale sia il male minore (e forse di farci sentire un po’ persone orribili).

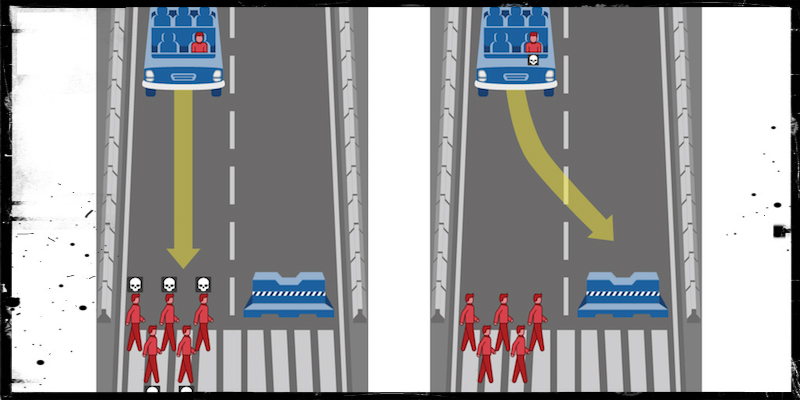

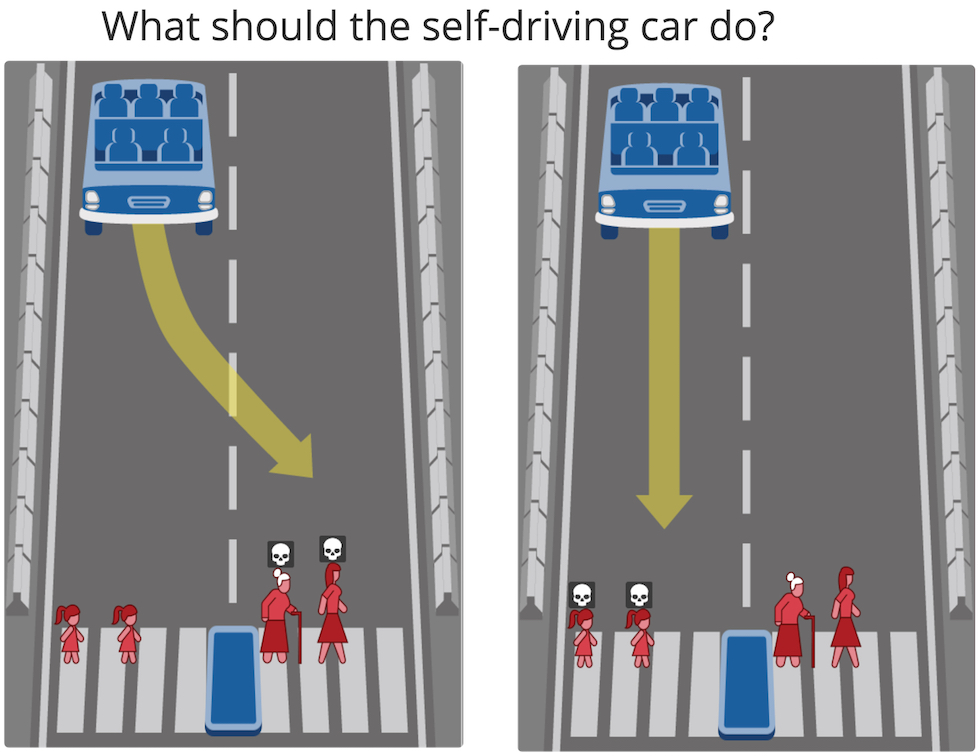

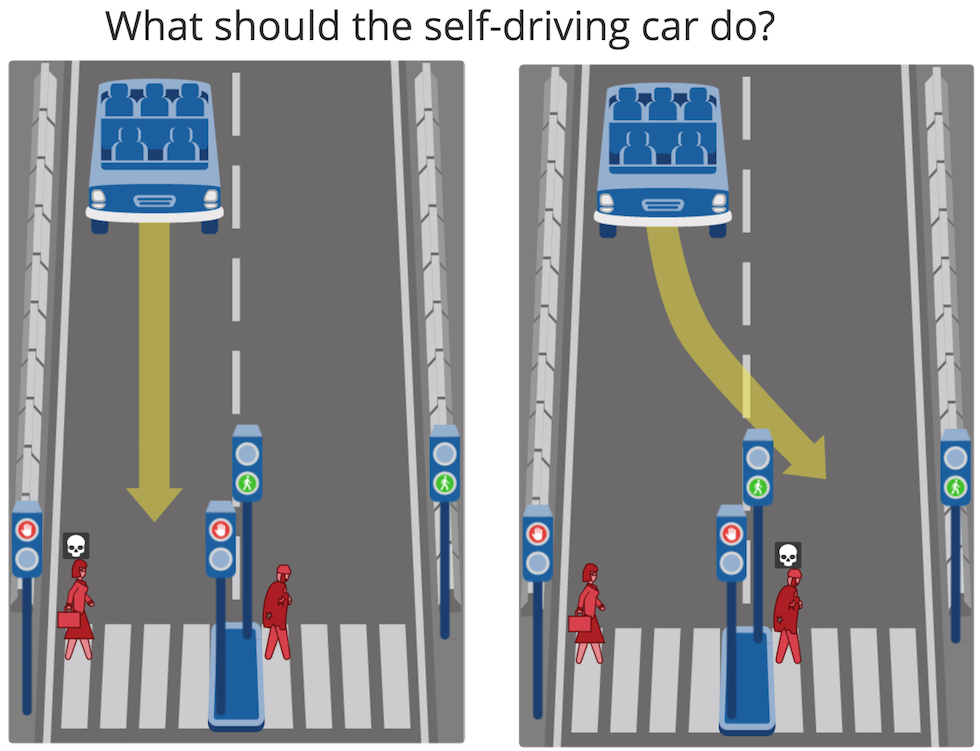

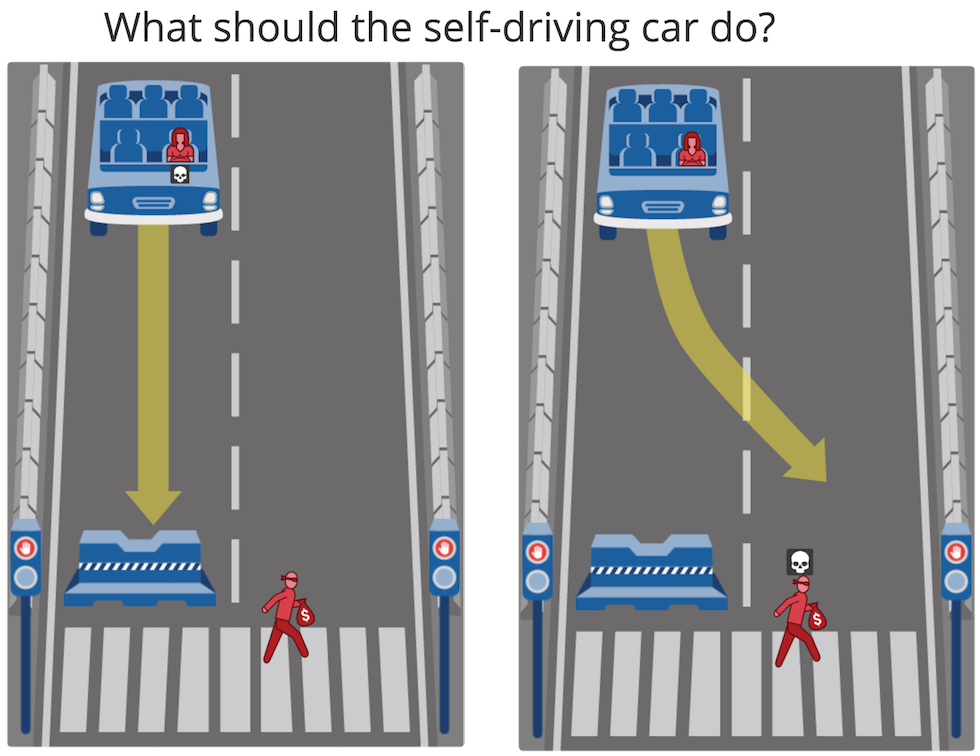

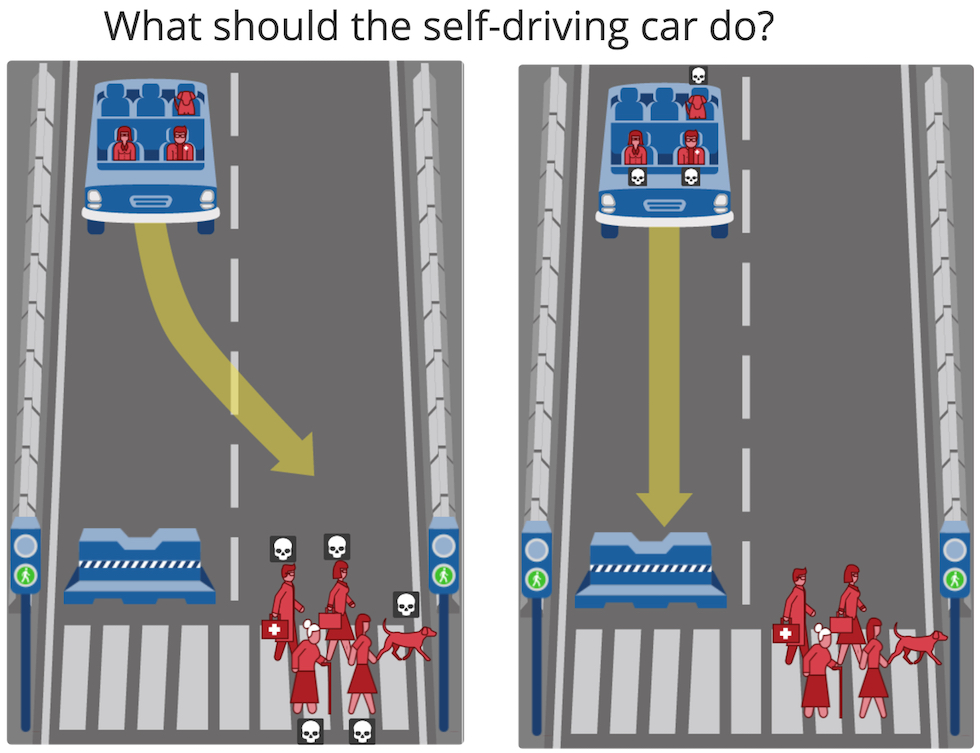

Il test etico di Moral Machine – a cui più di un milione di persone in tutto il mondo si sono sottoposte – è composto di tredici diverse situazioni in cui bisogna scegliere il male minore in due ipotesi di incidente. Per ogni test le situazioni proposte dal sito cambiano, ma tutte si dividono in tre categorie: quelle in cui l’automobile della simulazione deve scegliere chi investire tra due gruppi di pedoni (ed eventualmente animali), quelle in cui deve scegliere tra i propri passeggeri e un gruppo di pedoni che le stanno di fronte e quelle in cui la scelta è sempre tra passeggeri e pedoni, ma messi su un’altra corsia rispetto a quella di percorrenza.

Tra le prime ci sono quelle in cui l’automobile deve scegliere, ad esempio, se investire due bambini oppure due persone più anziane.

In altri casi la scelta proposta si basa su criteri meno condivisibili: ad esempio il caso in cui l’automobile deve scegliere se investire una donna che sta attraversando le strisce pedonali con il semaforo rosso, oppure un uomo che le sta attraversando con il verde. Il fatto che la donna sia una lavoratrice, o in particolare un medico, e l’uomo un senzatetto o un criminale, o viceversa, ha una qualche influenza sulla decisione quando in ogni caso il risultato finale è di un morto?

Quando nella scelta sono coinvolti anche i passeggeri dell’automobile si aggiunge un altro aspetto della questione: chi è a bordo deve avere diritto a qualche tipo di precedenza rispetto ai pedoni o ai passeggeri di altre automobili?

Per uno degli studi, degli stessi ricercatori che hanno realizzato Moral Machine, pubblicato nel 2015 su Arxiv ad alcune centinaia di persone è stato chiesto di immaginare scenari simili a quello dell’auto che si guida da sola che – in una strada tra due pareti come quella di questi esempi – deve scegliere tra andare contro il muro e investire i pedoni: immaginando di essere estranee alla situazione le persone hanno scelto nella maggior parte dei casi di sacrificare chi stava nell’auto, ma immaginando di essere loro a bordo in molti cambiavano idea, scegliendo di salvarsi. Per quello studio il 75 per cento delle persone disse di ritenere moralmente giusto evitare i pedoni, ma solo il 65 per cento disse di pensare che le auto che si guidano da sole dovrebbero essere programmate per farlo.

Dopo aver fatto il test etico di Moral Machine si può decidere di collaborare con i ricercatori del MIT dando alcune informazioni in più su di sé, in modo da spiegare le ragioni dietro le proprie scelte. Oltre all’età, al proprio genere, al livello di istruzione e a quello di fede religiosa, i ricercatori del MIT vogliono sapere quanto conta per noi nella scelta il fatto che alcuni pedoni attraversino col rosso e altri col verde, il fatto che alcuni siano donne e altri uomini, giovani o vecchi, in apparente buona salute o meno.

In una conferenza TED tenuta da uno dei ricercatori di Moral Machine, Iyad Rahwan, è spiegato che ovviamente le opzioni proposte dall’esperimento sono riduttive e non contemplano molte possibilità e variabili che si presenterebbero in una situazione reale: tuttavia per insegnare a una macchina a fare scelte etiche, usando un algoritmo o una tecnica di machine learning, è importante capire come la pensano davvero le persone in materia di etica. Il problema con l’etica però è che difficilmente si trova una posizione comune. Quasi tutti pensano che le auto che si guidano da sole dovrebbero minimizzare i danni in caso di incidente, ma al tempo stesso sembra che la maggior parte delle persone preferirebbero guidare automobili che mettano al primo posto la propria vita. I sondaggi fatti dai ricercatori hanno anche mostrato che le persone per risolvere la questione sceglierebbero di non usare auto che si guidano da sole, ma auto tradizionali, anche se un sistema di viabilità fatto solo di auto in grado di guidare da sole sarebbe complessivamente più sicuro di quello attuale.