L’arte artificiale

Come programmatori e artisti stanno sfruttando l'intelligenza artificiale per far creare ai computer opere d'arte, con alterni successi

Nell’estate del 2015 Google pubblicò una serie di strane immagini che secondo molte persone ricordavano le allucinazioni che si hanno dopo aver assunto sostanze come l’LSD, ma che in realtà erano state ottenute da un programma chiamato DeepDream a partire da immagini preesistenti. DeepDream, il cui codice è stato distribuito da Google in open source, si basa su una rete neurale artificiale, cioè su un insieme di computer in rete tra loro che si scambiano dati ed elaborazioni cercando di imitare la struttura di base del cervello umano (qui è spiegato più dettagliatamente). In pratica quello che fa DeepDream è prendere un’immagine, cercarci dentro schemi già noti (la forma di una banana, quella di un cane) e rielaborarla mettendoli in evidenza; il risultato sono immagini abbastanza strane, a volte quasi mostruose. Se non avete dimestichezza con l’LSD ma un po’ di più con la storia dell’arte, potrebbero ricordarvi Il giardino delle delizie di Hieronymus Bosch. Di solito nelle immagini realizzate con DeepDream si vedono molti occhi oppure strani animali.

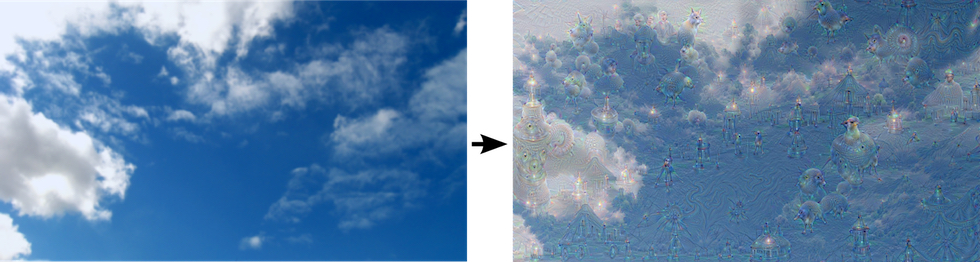

Come DeepDream ha rielaborato una fotografia del cielo; cliccate sull’immagine per osservarla meglio (Google)

Come DeepDream ha rielaborato una fotografia del cielo; cliccate sull’immagine per osservarla meglio (Google)

Google non ha realizzato DeepDream allo scopo di ottenere questo tipo di immagini o per realizzare un programma in grado di produrre arte, ma per scoprire più cose sul funzionamento delle reti neurali artificiali allenate con il deep learning a riconoscere le immagini. A questi sistemi vengono mostrate migliaia di immagini di un certo tipo di cose che gli si vuole insegnare a riconoscere (sempre qui è spiegato più dettagliatamente); ogni immagine passa in sequenza per ciascuno dei “neuroni” che formano la rete neurale artificiale e ognuno contribuisce alla risposta finale. Il primo neurone ad esempio guarda agli angoli e ai contorni distinguibili nelle immagini; i neuroni intermedi cercano forme definite più grandi, come la forma di una porta o di una foglia; i neuroni finali mettono insieme le interpretazioni di quelli precedenti.

Il funzionamento di questo processo si può intuire grazie a un videogioco di Google che si chiama Quick, Draw! ed è una specie di Pictionary con cui giocare insieme al proprio computer, o smartphone. Il gioco è piuttosto semplice: il sistema chiede di disegnare un oggetto che deve essere riconosciuto da un’intelligenza artificiale entro 20 secondi. Più il disegno è accurato, più l’AI ha probabilità di indovinarlo. Un’altra applicazione che usa lo stesso principio, sempre realizzata dalle squadre di ricerca di Google, è Auto Draw, che partendo da uno scarabocchio dell’utente gli permette di ottenere immagini semplici ma disegnate molto meglio (per ora è disponibile solo da browser, anche su smartphone).

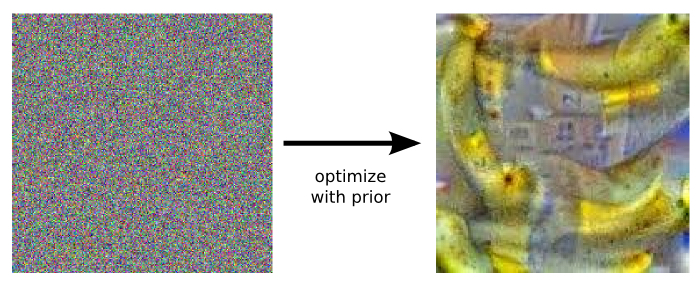

A Google hanno cercato di approfondire che cosa “capisse” esattamente ciascun elemento della rete neurale e per questo hanno fatto andare il sistema alla rovescia: gli hanno fornito un’immagine e gli hanno chiesto di ottenerne una seconda usando una specifica interpretazione. Ad esempio, mostrando all’AI un’immagine di pixel di diversi colori disposti in modo casuale le hanno chiesto di individuare delle banane.

(Google)

(Google)

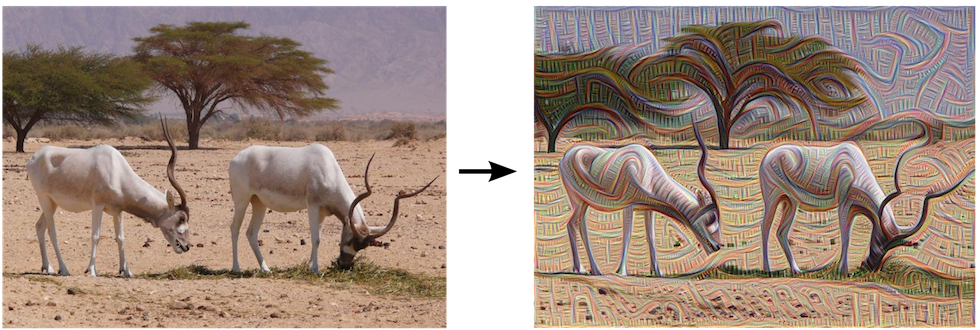

In questo modo hanno creato DeepDream e hanno scoperto che le AI costruite per riconoscere le immagini possono anche crearne. Oltre a chiedere al sistema di identificare una specifica forma, si può anche lasciare che sia il sistema stesso a sceglierne una: si istruisce l’AI a rielaborare un’immagine che le è stata fornita enfatizzando una forma vista da uno dei suoi neuroni. Per questa ragione alcune immagini ottenute con DeepDream sono più complesse o astratte di altre. Se si sceglie uno dei primi neuroni, si ottiene un’immagine modificata più a livello stilistico.

Cliccate sull’immagine per osservarla meglio (Google a partire da una fotografia di Zachi Evenor)

Cliccate sull’immagine per osservarla meglio (Google a partire da una fotografia di Zachi Evenor)

Se si sceglie uno degli ultimi neuroni, oppure se ottenuta una immagine rielaborata la si ripropone più volte all’AI, si ottengono cose più strane. Nell’orizzonte DeepDream può vedere un palazzo, in una foglia un uccello, in una nuvola strani animali fantastici.

Particolari dell’immagine del cielo rielaborata da DeepDream in cui si vedono strani animali, come il “maiale-lumaca” e il “cane-pesce” (Google)

Particolari dell’immagine del cielo rielaborata da DeepDream in cui si vedono strani animali, come il “maiale-lumaca” e il “cane-pesce” (Google)

Anche se DeepDream non è stato realizzato per produrre arte, molti artisti hanno provato a sperimentare con DeepDream per creare immagini artistiche (posto che ovviamente il concetto di arte è ancora più discusso di quello di intelligenza artificiale). Alcuni programmatori, ispirandosi a DeepDream, hanno creato software per applicare a fotografie uno stile pittorico, ad esempio quello dei famosi pittori ottocenteschi Pierre-Auguste Renoir o Vincent van Gogh. Uno di questi programmi, il primo, si chiama Style Newtworks. Una cosa simile potreste averla sperimentata se vi è capitato di scaricare e usare la app Prisma. Poi esiste Neural Doodle che invece permette di creare un’immagine in un definito stile pittorico a partire da uno scarabocchio.

Neural Doodles: Workflow Prototype for the Next Generation of Artist https://t.co/HjDTa8uxRn A future of #AI & #Art? pic.twitter.com/oUjLj7IZEM

— Alex J. Champandard 🌻 (@alexjc) March 9, 2016

DeepDream e altri programmi ispirati ad esso però non sono gli unici sistemi con cui si è provato a usare le AI nel campo dell’arte. Ad esempio, l’artista americano Ian Cheng – che tra le altre cose ha studiato scienze cognitive e ha collaborato con Industrial Light & Magic, l’azienda di effetti speciali digitali di George Lucas, e ha esposto alcune sue opere sia al Moma di New York che alla Fondazione Sandretto Re Rebuadengo di Torino – realizza “simulazioni live” in cui attraverso lo schermo di un tablet si può interagire con delle creature inventate (ad esempio un cane di razza Shiba, nell’opera Emissary Forks For You) regolate da un sistema di AI. Le opere di Cheng cercano di mostrare al pubblico i limiti e le possibilità delle AI e le rendono in forma di animali per rendere più chiare le loro caratteristiche.

Una interazione con Emissary Forks For You di Ian Cheng, una delle opere esposte al Moma nella mostra Emissaries fino al 25 settembre

Una interazione con Emissary Forks For You di Ian Cheng, una delle opere esposte al Moma nella mostra Emissaries fino al 25 settembre

Un altro progetto nel campo dell’arte e dell’AI è Recognition, realizzato dal centro di ricerca sulla comunicazione italiano Fabrica per la galleria d’arte di Londra Tate. Dal 2 settembre al 27 novembre 2016 all’interno del museo era possibile osservare sullo schermo come un sistema di AI trovasse associazioni visive tra fotografie dell’agenzia di stampa Reuters e immagini artistiche facenti parte dell’archivio della Tate. Il progetto ha vinto l’IK Prize 2016 per l’innovazione digitale, assegnato dalla stessa galleria d’arte.

Anche nel campo degli studi sulla storia dell’arte si usano forme di AI. Ad esempio, alla Rutgers University del New Jersey, negli Stati Uniti, esiste un Art and Artificial Intelligence Laboratory che si occupa di fare ricerche in questo ambito. Uno dei loro progetti consiste in un sistema di AI che misura la creatività di singole opere d’arte o di correnti artistiche guardando quanto abbiano influenzato altri artisti e si distinguano da altre opere d’arte o correnti. Esistono poi alcuni corsi universitari – pensati per chi ha già una laurea e vuole ulteriormente specializzarsi – dedicati alle intersezioni tra arte e tecnologia basata sulle AI. Ad esempio, l’Università di Londra offre un corso intitolato Machine learning and art (dedicato soprattutto alle sperimentazioni in campo musicale) e anche alla Tisch School of the Arts della New York University esiste un corso simile.